mwiederkehr

Expert Member-

Gesamte Inhalte

1.632 -

Registriert seit

-

Letzter Besuch

Alle erstellten Inhalte von mwiederkehr

-

Migration von Hosted Exchange zu On-Premises

mwiederkehr antwortete auf ein Thema von mwiederkehr in: MS Exchange Forum

Besten Dank. Ich musste übrigens den SCP (wie Du empfohlen hast) auf den alten Server setzen. Bei "$null" war das Objekt im AD vorhanden, aber ohne URL. Das hat Outlook auch nicht gepasst. Werde die Profile in der Registry entfernen. Es geht um ca. 200 User. Da es eine Pflegeinstitution ist, arbeiten da viele Teilzeit und in Schichten 24/7. Zugleich arbeiten sie nicht viel am PC und haben entsprechend wenig Erfahrung damit. Da hat lieber die IT etwas mehr Aufwand, dafür die User dann möglichst nichts zu tun damit. -

So richtig unangenehm ist der dritte, neu hinzugekommene Bug: Search error in Outlook cached mode after installing March 2024 SU

-

Proxy.pac für einen User auf einen bestimmten QAT Server unterbinden

mwiederkehr antwortete auf ein Thema von jon in: Active Directory Forum

Kannst Du den Benutzernamen im Link zur proxy.pac mitgeben? Also https://domain.de/proxy.pac?username=%username%. Dann kannst Du den Benutzer in der proxy.pac mittels const urlParams = new URLSearchParams(window.location.search); const username = urlParams.get('username'); abfragen. -

Migration von Hosted Exchange zu On-Premises

mwiederkehr antwortete auf ein Thema von mwiederkehr in: MS Exchange Forum

Besten Dank! Profil löschen per Registry oder gibt es einen besseren Weg? -

Migration von Hosted Exchange zu On-Premises

mwiederkehr hat einem Thema erstellt in: MS Exchange Forum

Hallo zusammen Ein Kunde will von Hosted Exchange (nicht Exchange Online) auf einen eigenen Exchange umsteigen. Ich habe in seiner Domäne einen Exchange installiert und die erste Befürchtung hat sich nicht bewahrheitet: Wenn Benutzer ein konfiguriertes Outlook haben, bleibt das Profil erhalten und stellt nicht wegen des SCP auf den internen Exchange um. Aber: Bei gemeinsamen Postfächern gibt es bei jedem Start von Outlook ein Autodiscover. Da geht er für diese Postfächer dann auf den internen Exchange. Ich habe das mit "Set-ClientAccessServer –Identity $servername –AutoDiscoverServiceInternalUri $null" unterbunden. Ginge das eleganter? ("ExcludeScpLookup" per GPO zu setzen, habe ich nicht als eleganter empfunden.) Wenn die Umstellung dann erledigt ist, was ist die empfohlene Vorgehensweise, um für alle Benutzer Autodiscover zu erzwingen? Die Autodiscover.xml-Cache-Datei löschen? Die OST-Datei wohl auch gleich, denn die passt ja nicht zum neuen Server? Oder ein neues Outlook-Profil erstellen? Ich kann mich diesbezüglich vage an NewProf.exe erinnern, aber das ist sehr lange her. Besten Dank für eure Tipps! -

Windows Lizenzen auf andere Hardware übertragen

mwiederkehr antwortete auf ein Thema von RealUnreal in: Microsoft Lizenzen

Sind es OEM-Lizenzen? Dann sind sie soviel ich weiss nicht übertragbar. Lizenzen, die über kostenlose Updates "erworben" wurden, sind meines Wissens an die Hardware gebunden. Wenn man ein Windows 7 kostenlos auf Windows 10 upgraden konnte, gilt die Lizenz für die restliche Lebenszeit des Rechners und nicht für andere Rechner (wo daraus dann ein kostenloses Windows 11 wird etc.). Baust Du die Rechner selbst? Falls die neuen Geräte mit Windows 11 ausgeliefert werden, gibt es kein Problem mit der Lizenz. Es wird dann die digitale Lizenz des neuen Rechners verwendet, ohne Eingabe eines Keys. Bei Office kannst Du mehrere Lizenzen zu einem Account hinzufügen. Ich weiss nicht, wie es aktuell aussieht, aber vor ein paar Jahren war das Portal noch unübersichtlich. Man hat nicht gesehen, welche Lizenz auf welchem Rechner aktiv war. Beim Verschieben wusste man somit nicht, welche Lizenz man deaktivieren muss. Bezüglich Sinnhaftigkeit schliesse ich mich Norbert an: Eine Installation auf Rechnern, die mit Windows 7 ausgeliefert wurden, wird um die zehn Jahre alt sein. Nach meiner Erfahrung braucht man da längst nicht mehr alle installierte Software. Da Du die Rechner ersetzt, kannst Du gut parallel eine neue Installation aufbauen. Allenfalls einem "Power-User" für einige Zeit alten und neuen Rechner gleichzeitig hinstellen mit einem KVM-Switch. -

Ich finde "Nextcloud-Server einrichten" nicht zu wenig komplex für 35 Stunden. Bedenke, dass die Dokumentation ungefähr die Hälfte der Zeit beansprucht. Die Dokumentation ist nicht nur IP-Adresse und Passwort, sondern sie soll Deine Überlegungen aufzeigen, wieso Du es so umgesetzt hast. Das ist viel mehr als nur "https://nextcloud.com/install.sh | sudo bash": Eventuell beginnst Du mit der Frage "Weshalb Nextcloud?" Falls das gegeben ist, geht es weiter: Weshalb hast Du Dich für die Distribution XY entschieden (Langzeitsupport, bestehender Einsatz in Firma...)? Wie viele Ressourcen benötigt Dein Server? Wie sieht das Partitionslayout aus? Welche Dateisysteme verwendest Du? Docker oder nicht? Weshalb? Welcher Webserver? Wie spricht der Webserver mit PHP? Welche Datenbank? Wo steht der Server im Netzwerk (DMZ, Hoster)? Performance-Optimierungen (Redis)? Dann noch eine Dokumentation, wie Updates eingespielt werden und allenfalls eine Kurzanleitung für Benutzer. Falls die Zeit dann wirklich noch nicht um sein sollte, kannst Du Themen wie Branding, Outlook-Integration etc. anschauen. Ich sehe immer wieder, dass bei solchen Arbeiten der Dokumentation zu wenig Platz eingeräumt wird. Dabei ist diese essenziell.

-

Von Windows 10 Home auf Windows 10 Pro upgraden mit Retailkey

mwiederkehr antwortete auf ein Thema von raymccoy in: Windows 10 Forum

Wenn eine digitale Home-Lizenz hinterlegt ist, kommt man mit einem Pro-Key nicht direkt auf Pro. Es heisst dann immer, der Key sei für die falsche Edition. Man muss zuerst mittels "Produktschlüssel ändern" den generischen Key "VK7JG-NPHTM-C97JM-9MPGT-3V66T" eintragen. Danach hat man Pro, aber natürlich nicht aktiviert. Zur Aktivierung trägt man dann den gekauften Pro-Key ein. -

Info: Windows 11 Updates am Admin vorbei - ab Patchday April 2024

mwiederkehr antwortete auf ein Thema von Squire in: Windows 10 Forum

Wenn sie solchen Unfug anstellen, müssen sie sich nicht wundern, wenn die Leute Windows Update deaktivieren... Schon nur der Dialog, Dark Pattern in Reinkultur: "Get it" und "Schedule it" prominent, "Keep Windows 10" versteckt. Das ist ein falsches Vorgehen, und zwar unabhängig davon, ob Windows 11 gut oder schlecht ist. Rechner mit Windows "Pro" sind zum Arbeiten da, ganz besonders, wenn sie in einer Domäne sind. Da haben keine Meldungen zu erscheinen, die den Benutzer von der Arbeit ablenken. Und der Benutzer hat auch nicht zu entscheiden, welches Betriebssystem installiert werden soll. Wenn man jemanden von Windows 11 (oder OneDrive...) überzeugen muss, dann den Admin. Unglaublich, zu was für einem unprofessionellen Gebastel Windows mittlerweile gemacht wird. Man stelle sich vor, andere Hersteller von Arbeitsgeräten würden das ähnlich machen. Die CNC-Fräse würde den Bediener plötzlich fragen "Heute ist Valentinstag. Soll ich hinter der Seriennummer ein Herzchen gravieren?" -

Microsoft geht mir mit EXO gerade ziemlich auf die Nerven ...

mwiederkehr antwortete auf ein Thema von Squire in: MS Exchange Forum

SPF und DKIM schützen vor gefälschten Absendern, aber nicht vor unerwünschten E-Mails. Insbesondere Phishing-Mails kommen häufig von tadellos konfigurierten Servern. Die Domain ist registriert, das TLS-Zertifikat stimmt, SPF und DKIM sind konfiguriert. Verdächtig (ausser des Inhalts) ist eigentlich nur die brandneue Domain. Der URL-Filter der FortiGate kann den Zugriff auf neu registrierte Domains blockieren. Mit der Hoffnung, dass Malware-Domains innert einer Woche abgeräumt werden oder auf der normalen Filterliste landen, ist das ein brauchbares Konzept. Ich könnte mir vorstellen, dass man in Zukunft bei Spamfiltern mehr in diese Richtung geht. -

Microsoft geht mir mit EXO gerade ziemlich auf die Nerven ...

mwiederkehr antwortete auf ein Thema von Squire in: MS Exchange Forum

Hier gilt leider das Recht des Stärkeren. Kommst Du als kleiner Anbieter auf eine Blacklist, weil einem Kunden im selben IP-Range das Joomla aufgemacht wurde, bekommst Du bestenfalls einen Link, um einen Antrag zur Entfernung von der Blacklist einzureichen. Steht ein grosser Anbieter auf einer RBL, bekommt man bestenfalls eine Liste mit IP-Ranges, die man seiner Ausnahmeliste hinzufügen soll. Nach Ansicht des (technisch nicht versierten) Kunden, liegt die Schuld keinesfalls beim grossen Anbieter... E-Mail ist kein schönes Geschäft mehr. -

RDP-Verbindung zu Terminalserver nicht mehr möglich

mwiederkehr antwortete auf ein Thema von WilhelmR in: Windows Server Forum

Der Verbindungsbroker läuft nicht richtig. Ich hatte das einmal, da lag es an einem ungünstigen Timing vom Start der Datenbank und des Brokers. Ein anschliessender Neustart des Brokers hat geholfen. Ich würde das einmal versuchen. Wenn er erneut Probleme beim Zugriff auf die Datenbank meldet, musst Du in diese Richtung weiter suchen. -

SQL Datenbank auf anderen SQL Server kopieren

mwiederkehr antwortete auf ein Thema von HeizungAuf5 in: MS SQL Server Forum

Ich weiss nicht, welche Daten eure Datenbank enthält und wie eure Entwicklungsumgebung aussieht, aber ich würde prüfen, ob Du nach dem Transfer nicht per Script gewisse Daten anpassen oder entfernen willst. Zum Beispiel die E-Mail-Adressen aller Kunden auf Deine Adresse setzen, sodass allfällige durch Tests ausgelöste E-Mails nicht an die Kunden gehen. Oder persönliche Daten entfernen. Mir ist ein Fall bekannt, wo eine Datenbank mit persönlichen Informationen über die Testumgebung auf dem Notebook eines Azubis gelandet ist, der sie in der Berufsschule als Anschauungsbeispiel verwendet hat. -

Powershell - SSL zu 15 Servern

mwiederkehr antwortete auf ein Thema von Quickly1971 in: Windows Forum — Scripting

Mit "Start-Process" vor "ssh" kannst Du ein neues Fenster öffnen. Befehle kannst Du nach dem Servernamen einfügen, aber dann ist es umständlich, die Rückgabewerte zu verarbeiten. Schau Dir doch mal https://github.com/darkoperator/Posh-SSH an. Damit kannst Du direkt in der PowerShell SSH-Sitzungen starten und Befehle ausführen. Bei 20 Servern könnte sich auch eine "richtige" Verwaltung mit Ansible oder so lohnen. -

Ich habe kurz recherchiert: Das war nicht wirklich ein Kinderbuch, sondern Teil einer Werbekampagne. Name und Titel des Autors sind erfunden. Das war virales Marketing anno 2008. Archive.org hat die englische Version: https://archive.org/details/mommybook/page/n11/mode/2up

-

Wie blendet man korrekt User aus der GAL aus?

mwiederkehr antwortete auf ein Thema von Nuce in: MS Exchange Forum

Die Probleme, die Dein Dienstleister wohl meint, liegen Jahre zurück. Bei Outlook 2010 konnte man kein Konto einrichten, wenn der Benutzer nicht in der Adressliste war und es gab Probleme mit dem Antworten an Benutzer, die nicht in der Adressliste waren (da intern die X.500-Adresse verwendet wurde und diese nicht geprüft werden konnte). Mit den Adressbuchrichtlinien, die mit Exchange 2010 SP2 eingeführt wurden, konnte man das umgehen. Anstatt einen Benutzer zu verstecken, hat man ihm eine andere Richtlinie zugewiesen, sodass er sich selbst immer im Adressbuch gesehen hat. Ich bin die letzten Jahre aber nie mehr auf ein solches Problem gestossen. Zudem müssen in Deinem Fall die versteckten Benutzer kein Outlook einrichten. -

Webserver mit Prä-Authentifizierung (Reverse-Proxy) veröffentlichen

mwiederkehr antwortete auf ein Thema von wznutzer in: MS Azure Forum

Mit Authentik und dem Nginx Proxy Manager sollte sich das realisieren lassen. Zertifikate (Let's Encrypt) wären damit auch gleich erledigt. -

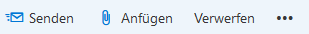

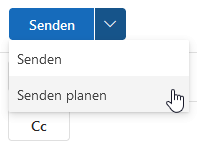

Outlook Übermittlungsoptionen

mwiederkehr antwortete auf ein Thema von possum72 in: MS Exchange Forum

Ja, stimmt. Exchange 2019: Exchange Online: Wenn dafür Outlook offen sein muss, ist es wirklich eine Funktion von beschränktem Nutzen. -

Outlook Übermittlungsoptionen

mwiederkehr antwortete auf ein Thema von possum72 in: MS Exchange Forum

Die Zeit ist leider nicht konfigurierbar für zukünftige Nachrichten, sie gilt immer nur für die aktuelle Nachricht. Man müsste wohl etwas mit einem Makro basteln. Bei OWA geht verzögertes Senden und die EWS-API bietet eine entsprechende Option. Zumindest früher ging es bei Outlook ohne eingeschalteten PC nur, wenn der Cache-Mode deaktiviert war. -

Aktuell noch ohne KI, aber trotzdem nützlich in solchen Fällen: https://github.com/mattparkes/PoShFuck

-

Starten von Anwendungen auf Server 2019 dauert lange

mwiederkehr antwortete auf ein Thema von Gu4rdi4n in: Windows Server Forum

Ich bin mir nicht sicher. Es wäre möglich, dass der SQL Server den Lookup erst macht, wenn man den Hostnamen des Clients anzeigt (zum Beispiel über sp_who2). Bei MySQL/MariaDB wird der Lookup bei jeder Verbindung gemacht, da Berechtigungen per Clientname vergeben werden können. Da ist ein Klassiker, dass lokal alles langsam läuft, wenn der localhost-Eintrag in der hosts-Datei fehlt. -

Starten von Anwendungen auf Server 2019 dauert lange

mwiederkehr antwortete auf ein Thema von Gu4rdi4n in: Windows Server Forum

Bei dem Fehlerbild fällt mir spontan DNS ein. Funktioniert die Auflösung in beide Richtungen? Also kann der Client den Servernamen in eine IP auflösen und der Server die Client-IP in einen Namen? -

Security für Admin-Accounts

mwiederkehr antwortete auf ein Thema von soulseeker in: Windows Forum — Security

Systeme mit Verhaltenserkennung funktionieren schon, wie es die Hersteller versprechen. "Client XY baut dauernd Verbindungen nach $bösesLand auf, das hat er bis jetzt noch nie gemacht, also Switchport deaktivieren und Admin informieren" ist technisch kein Problem. Nur ist das eigentlich zu spät und es entdeckt nur Wald-und-Wiesen-Angriffe. Die scheinen nicht mehr so lukrativ zu sein. Ich habe schon länger keine rechnung.zip.exe gesehen, die sofort alle erreichbaren Dateien zu verschlüsseln beginnt. Ja, solche Sachen sind leider sehr mühsam zum Aufräumen. Das will niemand anfassen und viele hoffen, es bis zur Pensionierung aussitzen zu können. -

Security für Admin-Accounts

mwiederkehr antwortete auf ein Thema von soulseeker in: Windows Forum — Security

Das Marketing wirkt leider und ich sehe immer wieder Firmen, die lieber Geld für "AI-enhanced Cloud Security" oder "Managed Detection and Response" ausgeben als für organisatorische Massnahmen, obwohl letztere aus meiner Sicht mehr bringen würden. So trifft man immer noch Umgebungen an, in denen der Azubi sich als Domain-Admin auf dem Printserver einloggt, um im Internet nach Druckertreibern zu suchen. Oder Scripts per Taskplaner als Domain-Admin ausgeführt werden, aus für Benutzer schreibbaren Verzeichnissen. Aber man fühlt sich gut geschützt durch "360° Total Insight Premium Cloud Edition". -

userPrincipalName mit mail-Adresse abgleichen

mwiederkehr antwortete auf ein Thema von Garant in: Windows Forum — Scripting

Die Empfehlungen erlauben Rückschlüsse auf das Alter: - PowerShell ohne Rücksicht auf CPU: jung - PowerShell mit Gedanke an CPU: etwas älter - CSVDE: noch etwas älter