Weingeist

Members-

Gesamte Inhalte

1.667 -

Registriert seit

-

Letzter Besuch

Alle erstellten Inhalte von Weingeist

-

Standard-Apps - keine App zum Ausführen zugeordnet

Weingeist antwortete auf ein Thema von Flensburg100 in: Windows 10 Forum

Könntest mal das Profil des Benutzers auf dieser Kiste löschen. Alternativ - wenn er ned erfreut sein würde wegen x-einstellungen - auch einfach mit einem Beutzer versuchen, der sich noch nie an der Mühle angemeldet hat. Wenn da das Probleme auch auftritt, ist es vermutlich die Kiste, sonst eher das Benutzerprofil. -

KMS-Server in anderer Domäne?

Weingeist antwortete auf ein Thema von guybrush in: Windows Server Forum

Ob der KMS dagegen auf den DC sollte? ;) -

Standard-Apps - keine App zum Ausführen zugeordnet

Weingeist antwortete auf ein Thema von Flensburg100 in: Windows 10 Forum

Das ist ein aktueller Bug von Windows 10. Eigentlich vom Oktober-Update und nicht von 1803. Evtl. ist er weg wenn Du das neue Oktober-Update drüberbügelst. -

Windows 10 Installationsproblem - bootable device not found

Weingeist antwortete auf ein Thema von regiweb in: Windows 10 Forum

Du hast noch immer nicht gesagt was im BIOS als Bootreihenfolge explizit drinsteht und ob Du diese angepasst hast. Die Toshiba hast Du also manuell komplett gelöscht? Nach den ganzen vorherigen Versuchen? Die SSD auch? --> da war vorher ja die Systempartition drauf und die muss auch erstmal weg, sonst sind da bootinfos drauf für die andere Platte obwohl die eigene hat. Irgendwie passt Deine aktuelle Beschreibung ganz und gar nicht zu meinem Erfahrungen. Daher nochmal von vorn, alles an Partitionen löschen mittels diskpart, damit beide Disks leer sind. Dann die SSD vor-partitionieren damit keine System Partion darauf erstellt werden kann. Dann nochmals auf der Toshiba installieren. -

Mehr Leistung beim Arbeiten mit Excel Dateien

Weingeist antwortete auf ein Thema von softcon in: Windows 10 Forum

Da würde ich auch erstmal Speicher nachschieben. CPU Belastung geht auch rauf? -

Mehr Leistung beim Arbeiten mit Excel Dateien

Weingeist antwortete auf ein Thema von softcon in: Windows 10 Forum

Nicht alles was man mit Excel anstellt ist mit einer DB auch einfach abgebildet. Insbesondere nicht einfach abgeändert wenn sich neue Ideen bilden. ;) Ist der Excel-Teufel einer der auch VBA mit eigenen Makros benutzen tut? Dann hilft oft nur eine GHZ-Starke CPU da diese Funktionen eigentlich nur Single-Core ausgeführt werden. Ich nehme für Workstations der Power-User immer CPU's mit über 3GHZ. Das bringt für das User-Feeling oft am meisten (neben der SSD). Dazu muss die Anzeige im Ressourcenmonitor nichtmal immer bei 100% stehen um trotztdem eine massive Verbesserung zu haben. Auch das abdrehen der 100'000 Aufzeichnungen die Windows betreibt bringt auf gut genutzten Workstations eine teilweise spürbare Verbesserung. Ansonsten kann man gängige Vorgehensweisen teilweise schon in der Performance verbessern indem man die genutzen Funktionen und die herangehensweise an die Probleme überprüft. Komplexe Berechnungen sind z.B. oft schneller per spezifscher VBA-Funktion gelöst als tief verschachtelter und voneinander abhängige Formeln. Ist halt unter Umständen nicht mit der Policy vereinbar. 64bit hilft eigentlich nur wenn tatsächlich RAM das Problem ist, sonst wird Excel oder allgemein die Office Apps tendenziell eher langsamer wie schneller. Ist aber mehr ein Gefühl wie tatsächlich per Bench geprüft. Schafft manchmal noch sonstige Probleme (wenn mit AddIns gearbeitet wird, was die PowerUser gerne mal tun). -

Windows 10 Installationsproblem - bootable device not found

Weingeist antwortete auf ein Thema von regiweb in: Windows 10 Forum

Die Toshiba hast also nicht partitioniert? Die Partition hast Du nach der ersten und vor der erneuten installation wieder gelöscht? Sonst geht es logischerweise auch nicht, da die festplatte bereits durch die letzte Installation partitioniert worden ist. Das wäre dann wie das beschriebene vorgehen zum verhindern der Systempartition. Dann muss aber der Active-Flag gesetzt werden. ;) Sprich z.B. mit Diskpart die Partition auf der toshiba löschen, damit wieder eine jungfräuliche Disk präsentiert wird. Geht glaub sogar in der GUI, indem Du die Disk markierst und alles löschen klickst. -

Windows 10 Installationsproblem - bootable device not found

Weingeist antwortete auf ein Thema von regiweb in: Windows 10 Forum

Irgendwo muss die auftauchen, sonst wird davon auch nicht gebootet. Evtl. ist sie aber als USB oder PCI-Express angebunden, dann muss Removable USB Devices oder wie auch immer das in deinem bios heisst nach unten schieben bzw. die Toshiba ganz nach oben. Mit Diskpart hast nur die SanDisk partitioniert? -

Windows 10 Installationsproblem - bootable device not found

Weingeist antwortete auf ein Thema von regiweb in: Windows 10 Forum

Etwas seltsam ist das aber schon. Wenn sich keine Bootinformationen auf einem Datenträger findet, sollte die Kiste einfach solange die nächsten Platten durchgehen, bis sie Bootinfos findet. Insofern vermute ich, dass die Platte gar nicht in der Bootreihenfolge auftaucht. Oder aber Du hast nicht nur die kleine Platte mit Diskpart partitioniert, sondern auch die grosse. Wenn Du das gemacht hast, dann musst Du auch der Befehl Active auf die Partition setzen, damit die Partition als Bootpartition des Datenträgers erkannt wird. Dann fehlt dir aber die Systempartition. Ich mache das manchmal bewusst so, um sie weglassen zu können. Kannst das auch mal im Nachhinein testweise versuchen, nachher die Installation einfach abbrechen (da schon installiert). Wenn Du das ausschliessen kannst, bleibt dir nichts anderes übrig als das BIOS durchzuackern ob es irgendwo eine Einstellungen gibt. Unter Umständen ist der Controller an dem die Platte hängt, gar nicht für Boot aktiviert, im schlimmsten Fall auch nicht aktivierbar. Dabei kann die Einstellung ob die Platten des Controllers erscheinen irgendwo sein und nicht absolut zwingend unter Boot. -

Windows 10 Installationsproblem - bootable device not found

Weingeist antwortete auf ein Thema von regiweb in: Windows 10 Forum

Normal sollte es völlig ausreichen, wenn du Die SanDisk vorgängig partitionierst. Dann wird da auch nix draufgeschrieben. Das geht indem Du sobald das Fenster mit der Auswahl für die Disks kommt wohin installiert werden soll mit Shift + F10, das öffnet die Kommandozeile. Mit dem Tool Diskpart.exe kannst nun die Disks formatieren. 1. Mit List Disk herausfinden welche Nr. die SanDisk hat 2. Mit Select Disk X (x=nr der Disk) die Disk auswählen 3. Mit Create Partition Primary eine Partition erstellen Theoretisch müsste es bis hier schon ausreichen, falls nicht, noch ein Filesystem draufpacken: 4. Mit List Volume die Volume Id herausfinden (normal dürfte das 0 oder 1 sein, weiss ich grad nimmer auswendig) 5. Select Volume X (x=nr des Volumes) 6. Format fs=ntfs quick 2x Exit Die Ansicht im Install-Fenster aktualisieren und diegewünschte Disk für die Installation auswählen. Normalerweise sollte Windows jetzt nichts mehr auf dieser Disk erstellen. Das Verfahren kann auch verwendet werden um zu verhindern, dass diese Systempartition überhaupt erstelt wird indem die ganze Disk wo Windows drauf soll, ebenfalls vorpartitioniert wird. Da braucht es dann noch den Befehl Active bei der Partition von der gebootet werden soll. -

Windows 10 Pro im Unternehmen: DSGVO-konform?

Weingeist antwortete auf ein Thema von Sherminator in: Windows 10 Forum

Es dürfte wohl kaum jede noch so kleine Firma die Ressourcen haben sich dahingehend umfangreich im Detail beraten zu lassen. Daher muss man sich wohl oder übel an solche Massnahmen halten damit Aufzeichnung und Übermittlung von Daten möglichst verhindert wird. Wird möglichst nix aufgzeichnet und übermittelt, hat man auch "viel" gemacht um die Anforderungen zu erfüllen. Von MS gibt es übrigens eine Liste mit ein paar Erklärungen dazu wohin sich welche Programme verbinden. Auch wenn es ewig gedauert hat undunter dem Namen Endpoint etwas gut versteckt ist, finde ich das für einmal vorbildlich. Manch einer wird erschrecken wie lange sie ist. Lustig finde ich, dass sie wohl selbst keine Ahnung haben was sie überhaupt wohin übermitteln und einschlägige Tools für die Analyse hernehmen mussten. ;) https://docs.microsoft.com/en-us/windows/privacy/manage-windows-endpoints https://docs.microsoft.com/en-us/windows/privacy/windows-endpoints-1709-non-enterprise-editions https://docs.microsoft.com/en-us/windows/privacy/windows-endpoints-1803-non-enterprise-editions Die Hürden für das vollständige Abdrehen sind zwar nach wie vor ziemlich gross, aber wenigstens kann man mal die Kommunikation unterbinden. Zumindest bis wieder Änderungen mit neuen Builds gemacht werden. Einfache Windows-Firewall-Regeln ziehen übrigens nicht zwingend, da es teilweise explizite Ausnahmen für manche Dienste in der Registry gibt (Static/Configurable). -

Server2016 - NTFS-Rechte Homelaufwerk

Weingeist antwortete auf ein Thema von Jian in: Windows Server Forum

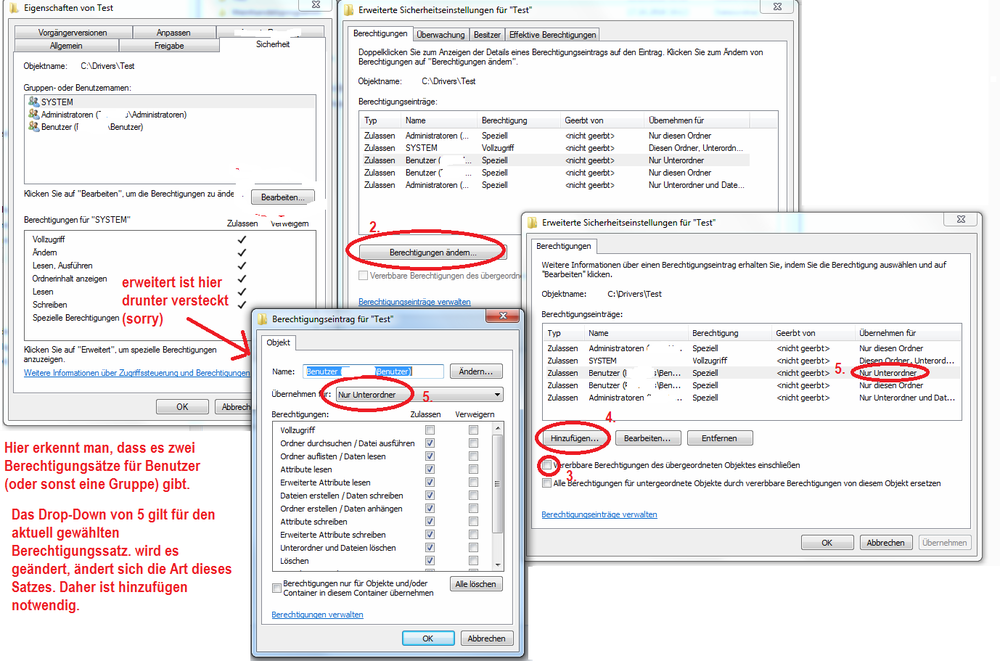

Jetzt verstehe ich auch was Du erreichen möchtest. Sie sollen den Ordner selber nicht umbenenen können, innerhalb des Ordners aber dennoch Schreibrechte haben. Das ist etwas tricky. Lösen kannst Du es, indem Du mit den erweiterten Einstellungen jweils für alle Gruppen zwei Berechtigungssätze erstellst. Einen Satz für diesen Ordner UND einen Satz für Unterordner und Dateien. Gleichzeitig musst Du auf dem Hauptornder selber die Vererbung deaktivieren, damit Du granulare Einstellungen treffen kannst bzw. diese nicht überschrieben werden von oben. Die granularen Einstellungen gibt es dann nur unter Erweitert, also der Button ganz unten im Sicherheitsfenster. Da deaktivierst Du die Vererbung (kannst ja der einfachheit halber die Rechte kopieren und dann abändern). Da legst Du Leserechte für alle fest (für diesen Ordner). Der Zweite Satz (Button hinzufügen für die gleiche Zugriffsgruppe) stattest Du für die gleiche Gruppe mit Schreibrechten für Unterordner und Dateien aus. Wenn Du das im gleichen Fenster machst, dann überschreibst das vorherige. Du musst also zwingend eines hinzufügen. Der Wechsel des Dropdowns = überschreiben des aktuellen Satzes und nicht das setzen von zusätzliches Rechten. Wenn Du auch den Admin Schreibrechte wegnimmst, aber Zugriff auf Sicherheitseinstellungen erlaubst, dann poppt auch bei denen ein UAC auf und wird so nicht versehentlich geändert. EDIT: Habe noch eine Grafik hochgeladen, falls es etwas kompliziert zu verstehen ist. =) -

Software zu Desktop-Benachrichtigung gesucht

Weingeist antwortete auf ein Thema von zahni in: Windows Forum — Allgemein

Windows 10 hat ja so ein Benachrichtigungscenter, evtl. kann man da selber auf irgend eine Weise Nachrichten generieren. Wäre dann ohne Drittanbieter Software auf den Clients möglich. Vielleicht gibts sogar ein Drittanbieter Tool welches eine allfällige Schnittstelle seitens Windows dafür nutzt, also das man Zentral Nachrichten für die Clients generieren kann. Ist aber nur so eine Idee wie man den Kram sogar mal sinnvoll nutzen könnte, sofern so vorgesehen. Wäre mir, sofern es den Anforderungen genügt, sympathischer als ein separates Tool das auf alle Clients ausgerollt werden muss. -

Bildqualität Remote Desktop Server 2016

Weingeist antwortete auf ein Thema von marsl84 in: Windows Server Forum

Hast mal Versucht in den Verbindungseinstellungen LAN zu erwzingen? --> Reiter Leistung Es gibt da noch eine GPO welche die serverseitige Hardwarebeschleunigung aktiviert wenn der RDP auf Blech läuft. Dürfte seite ungefähr Version 2012 der Fall sein. Vorher war die Grafikbeschleunigung ja grösstenteils Sache des Clients. Administrative Vorlage>Windows Komponenten>Remotedesktopdienste>RemoteDesktopsitzungshost>Umgebung für Remote Sitzung>Standardhardwaregrafikadapter für alle RDsitzungen verwenden. Funktioniert normalerweise solange der RDS auf Blech läuft, evtl. auch bei VMs mit 2016, da wurde ja einiges geändert. Vielleicht läuft es jetzt weil der gesetzt ist schlechter oder weil er nicht mehr gesetzt ist. Weiss ehrlich gesagt nicht ob er bei gesetzter Haken clientseitiges Rendering nimmt wenn da mehr Power vorhanden ist. Ein Versuch es jedenfalls wert mit dem Wert zu spielen. =) Ich tendiere aber stark dazu, dass Du bei dieser Grake alle einstellungen entfernen solltest, die auf serverseitiges rendering hinaus laufen. Also die meisten der neuen Features von RemoteFX. EDIT ändern kannst die GPO nur lokal mit gpedit oder mit dem DC. -

Windows 2016 VM hängt nach Update

Weingeist antwortete auf ein Thema von Dutch_OnE in: Windows Server Forum

Was dagen oft hilft: Vor den grossen Updates einen Neustart durchführen. Mache das mittlerweile auf Servern fast konsequent. Auf "grossen" Workstations mit Speicherintensiven Programme wie CAD, Grafik, Dongle-Kram etc. ebenso (die entladen gerne mal nicht so sauber). Da laufen die Updates - auch grosse - eigentlich immer super flauschig durch. Der neustart ist bei VM's ja in ein paar Sekunden erledigt. Ansonsten hast vielleicht auch einfach zu wenige Power. IOPS, CPU oder RAM. Wenn dann ist meist ersteres der Fall. ;) Was ich aber auch schon hatte (unter VmWare) ist die Tatsache, dass ich nach dem Update nicht mehr per RDP auf die Maschine kam sondern nur per Konsole und erst nochmals ein neustart gemacht werden musste. Wirklich reproduzieren konnte ich das nie, trat aber in der Vergangenheit sporadisch auf. -

Windows Server 2012 R2 Scann Server einrichten?

Weingeist antwortete auf ein Thema von Ecomatic_Driver in: Windows Server Forum

Normalerweise ist das ein Scan-Treiber von deinem Druckerhersteller der das könnte. Nur ist das uralte, nicht mehr wirklich weiterentwickelte Technik (Twain). Ist zudem 32bit und nicht richtig 64bit tauglich. Die wird eigentlich nur bereitgestellt, damit die Hersteller sagen können, dass sie es eben können. Damit handelst Du dir sogar mit den besten Multifunktionsgeräten der grossen Hersteller nur Ärger ein, von den kleinen reden wir gar nicht. Läuft (fast) alles unter dem Stichwort unbefriedigend bis völlig unbrauchbar im täglichen Einsatz. Oft muss am Device erst eingestellt werden, dass man sich jetzt mit EINEM PC verbindet, das Device ist dann für alle anderen gesperrt, da die Treiber nicht Multi-Link-Fähig sind. Nach dem Scan muss es wieder deaktiviert werden, damit man von einem anderen PC scannen kann usw. Kopieren ist auch bis dahin blockiert. Vergisst ein MA die Freigabe gucken andere in die Röhre. Geht also ein anderer MA an das Gerät, kann er es in der Regel nicht mehr bedienen. Mögliche Alternative: - Eines oder mehrere Shares auf einem File-Server, Dienstkonto für den Scanner damit es sich gegen den Fileserver authentifizieren kann - Scan in das Share auf dem Fileserver, ein Share kann auf den guten Geräten als Ziel im Adressbuch definiert werden. Funktioniert dann ähnlich wie ein Fax. - Der Ma holt sich dann sein Dokument vom Fileserver wenn er wieder am Arbeitsplatz ist -

Server2016 - NTFS-Rechte Homelaufwerk

Weingeist antwortete auf ein Thema von Jian in: Windows Server Forum

Bist Du Dir sicher, dass nicht Write-Rechte vererbt worden sind? Habe zwar noch keine produktive Server 2016 Umgebung (mir ist die App-GUI mit ihren 100 Firewall-Freigaben pro User und die IOPS für die Telemetrie immer noch ein graus, Datenschutz ganz zu schweigen), aber ich kann mir nicht vorstellen, dass MS eine Freigabe-Write-Berechtigung an NTFS weiterreicht. -

Bildqualität Remote Desktop Server 2016

Weingeist antwortete auf ein Thema von marsl84 in: Windows Server Forum

Den Unterschiede finde ich persönlich ziemlich krass. Habe ich so noch nicht gesehen bei identischer Hardware. Allerdings ist der Vergleich nicht fair, da das erste Bild deutlich grösser ist, als das zweite. Das kann eine Menge verzerren wenn die Quelle (Bildauflösung) die selbe ist. Quasi Verlustfreies Upscaling ist jetzt nicht unbedingt die Stärke von Windows. Etwas vom wichtigsten bei RDP: Erfolgt der Zugriff über den gleichen Client wie vorher oder wurde auch hier etwas an Hardware getauscht? Falls ja, was wurde durch was ersetzt? -

Storage Replication - Gleicher Server usw.

Weingeist antwortete auf ein Thema von Weingeist in: Windows Server Forum

Danke für den Input, aber Nochmals, wofür ich es einsetze ist allein meine Sache. Ich nehme für mich in Anspruch, dass ich weiss was ich tue. Nicht dass man etwas nicht besser machen könnte, aber beurteilen ob es am Ende für mich - und niemand anderen - etwas taugt, dass kann ich sehr gut. Ob nun die Funktion ursprünglich für etwas anderes gedacht war, ist mir total egal. So manches was im grossen Umfeld nicht gescheit funktiniert, da es zu viele Ressourcen verbratet, ist im kleinen Umfeld eine nette Hilfe, da Leistung eh im Überfluss vorhanden ist. ;) Von daher, - wenn Du kannst und willst - sage mir etwas zur technischen Seite der Funktion. Sprich etwas zu den Fragen die ich im ersten Post formuliert habe. Wenn sich niemand findet, werde ich es eben wie bereits bei den Storage Spaces wieder selber alles komplett durchtesten. Da es die Funktion schon länger gibt, dachte ich, dass es vielleicht schon jemand gemacht hat und mich an den Erfahrungen teilhaben lässt. Irgendwie flog der OS-interne Teil davon - was für mich hauptsächlich interessant wäre - irgendwie immer unter meinem Radar. Gruss und Danke -

Netzwerkprobleme können leider viele Ursachen haben. Ereignislog prüfen wurde Dir ja bereits gesagt. Bekommst Du mit Ipconfig eine Fantasieadresse oder die korrekte IP? Wenn Du den Netzwerkadapter deaktivierst und im Anschluss wieder aktivierst, klappt es dann oder nicht? Klappt es wenn Du den Rechner komplett stromlos machst? Also Stecker/Batterie raus bis alles an Lämpchen erlöschen? (30 Sek Regel) Du schreibst zudem, dass du IPv6 deaktiviert hast. Was hast Du alles gemacht? Einfach das Protokoll im Netzwerkadapter abgewählt oder auch in der Registry Teile der Components deaktiviert? 6to4 Kram wie Teredo etc. deaktiviert oder noch aktiv? IP-Hilfsdienst ebenfalls deaktiviert? An die Anpassung der Prefixpolicy gedacht? --> Wenn man an IPv6 rumschraubt, sollte das immer komplett durchgezogen werden, sonst führt es je nach Situation auch zu Problemen. EDIT: Du schreibst noch etwas von einem Switch, ist das so ein kleines 5-Port-Teil oder was grösseres? Die kleinen haben mit der Zeit gerne mal Netzteil-Probleme, da wird teilweise massiv gespart. Sobald die Kondis etwas ausgetrocknet sind, funktioniert die Spannungsglättung nicht mehr korrekt oder sie können schlicht die Spannung nicht mehr halten. Je mehr Ports belegt sind, desto grösser die Probleme. --> Testweise mal tauschen, unbedingt mit dem Netzteil, kostet ja nur ein paar Euros. Wenn Du genügend schnell bist bevor die Elektronik des Switches Schaden genommen hat, reicht es oft auch aus, das Netzteil gegen etwas hochwertigeres zu ersetzen. Einer der Gründe warum ich die Teile nur sehr ungerne verbaue und nach Möglichkeit/Budget/Platz neue Kabel direkt von den Hauptswitches ziehe.

-

Windows DNS: Registrierung von AAA-Records deaktivieren

Weingeist antwortete auf ein Thema von zahni in: Windows Forum — LAN & WAN

Den ganzen Kram deaktiviere ich (fast) seit es ihn gibt mit nem Script. GPO ist dann mehr "Polizist". Am Ende des Script deaktiviere ich dann auch den dazugehörenden Dienst (IP-Hilfsdienst). Der bringt ausser potentiellen Ärger eigentlich nichts. Läuft der IP-Hilfsdienst nicht, funktionieren auch die ganzen Tunneladapter für 6to4 nicht. Ich persönlich ändere auch immer die Prefix-Policy damit IPv4 gegenüber IPv6 bevorzugt wird. Das ist zwar nicht "modern" aber zumindest einfacher in der Handhabung bei der lokalen Fehlersuche. Wer mit der Deaktivierung von IPv6 liebäugelt MUSS quasi die Policy anpassen, da es sonst Konnektivitäts-Probleme gibt. -

Schattenkopie in den Laufwerkseigenschaften

Weingeist antwortete auf ein Thema von michaR in: Windows Server Forum

Das Verhalten ist schon länger so. Läuft unter dem Register "Vorgängerversionen". Die Konfiguration dagegen ist ein direkter Menüeintrag im Kontextmenü und nennt sich "Schattenkopien konfigurieren". -

Storage Replication - Gleicher Server usw.

Weingeist antwortete auf ein Thema von Weingeist in: Windows Server Forum

@NilsKDie Anforderung ist hier, dass ich wissen möchte, was die Funktion technisch tatsächlich kann und in welcher OS-Version es verfügbar ist und nicht was ich damit anstellen kann/soll/muss. Kann es aber gerne trotzdem ausführen: Das Ziel ist im Endeffekt, mir Zeit, Nerven und Diskussionen zu sparen. Das heisst die Daten eines Fileserver sollen ohne den Luxus von 10Ggbit und anderen Enterprise-Features möglichst schnell wieder oben sein ohne sehr viel Geld in die Finger zu nehmen. Ob das jemand anders als sinnvoll erachtet ist mir dabei völlig egal, mir spart es im Fehlerfall sehr viel Nerven und Zeit bzw. schafft mir bei RAID-Rebuild-Fehler Zeit bevor ich vor Ort sein muss. Desaster-Recovery war auf das Replikat bezogen strenggenommen der falsche Begriff, nicht jedoch auf die Situation die unter Umständen ensteht wenn in kleinen Umgebungen ein Server abraucht. Die Wiederherstellung des lauffähigen Zustandes ist dann eben selektiv. Ein Teil (OS) aus dem Backup, ein Teil (Daten) aus dem Replikat. Alleine aus Geschwindigkeitsgründen. Sollte das Replikat der Daten ebenfalls tot sein, kommt es eben trotzdem aus dem Backup. (Worst Case) -

Storage Replication - Gleicher Server usw.

Weingeist hat einem Thema erstellt in: Windows Server Forum

Hallo Leute, Beim Durchstöbern von https://docs.microsoft.com/en-us/windows-server/storage/storage-replica/storage-replica-overview Bin ich auf folgende Aussage gestossen: "Storage Replica also has a server-to-self mode, where you point replication to two different volumes on the same computer." - Muss es bei einem Reboot oder Kaltstart wieder angeschubst werden oder geschieht das automatisch? (Egal ob gleicher Server oder zwei verschiedene) - Ist das Server-Intern crashresistent? Sprich passiert auf File-System-Ebene nicht viel wenn z.B. der Stecker gezogen wird? (metaphorisch gemeint, kann ja auch BlueScreen oder sowas sein) - Server-Intern auch nur ein Datacenter-Feature? Vermute DC - Funktioniert das auch mit Dedupe-Volumes zuverlässig? Wird Dedupe beibehalten oder ist es ein Feature des Ziels? Eigentlich müsste es das ja, wenn alles Blocklevel-basiert ist - Werden File-System Fehler mitkopiert oder ist das gänzlich unabhängig? Da Blocklevel, schätze ich mitkopiert. Wäre vielleicht eine gute Ablösung für diverse Robocopy Mirror's die ich gerne als schnell verfügbare Desaster-Kopie von Fileservern in Umgebungen mit eher kleinem Budget vorhalte. Auch ein RAID-Rebuild mit grossen, lahmen Festplatten wäre dann keine Zitterpartie mehr weil man immer eine Topaktuelle Kopie in petto hat und nicht eine von letzter Nacht. Wenn das sogar für laufende VM's mit VSS tauglich ist, auch recht nett (zumindest solange die Applikationen nichts gegen Kaltstarts haben oder die Applikation eben VSS unterstützt.). Insgesamt - sofern ich das richtig interpretiert habe - mal ein richtig guter Upgrade-Grund von 2012R2 auf 2016. Auch in einer Kleinumgebung. :) Grüsse und vielen Dank -

WSUS auf Srv 2016 lastet RAM aus

Weingeist antwortete auf ein Thema von Kuddel071089 in: Windows Server Forum

@Sunny61: Stimmt, WID ist wohl - seit geraumer Zeit - eine gute Alternative. Danke für den Hinweis. Bezüglich der Pipe: Die richtige Syntax für die Verbindung zur Pipe steht trotzdem im Konfigurationsmanager. Wenn da ein $ Zeichen in der Pipe steht - aus welchem Grund auch immer und sei es nur weil es jemand geändert hat -, dann braucht es für die Verbinung auch ein $ Zeichen und nicht den Backslash. Korrekt ist aber sicher - habe ich nun auch mit einer etwas neueren Installation als meiner eigenen nachgeprüft - das es standardmässig so lautet wie Du es gesagt hast und demzufolge auch so bleiben sollte.