-

Gesamte Inhalte

2.105 -

Registriert seit

-

Letzter Besuch

Alle erstellten Inhalte von BOfH_666

-

Mit wsh Script verzeichnisse löschen

BOfH_666 antwortete auf ein Thema von DaniW in: Windows Forum — Scripting

Sagst Du uns vielleicht trotzdem noch, warum es unbedingt WSH sein soll? Ich würde es gern verstehen. -

Mit wsh Script verzeichnisse löschen

BOfH_666 antwortete auf ein Thema von DaniW in: Windows Forum — Scripting

Ich bin neugierig - warum soll es denn unbedingt WSH sein, wenn ich fragen darf? -

Aus Outlook eine bat ausführen bei Maileingang

BOfH_666 antwortete auf ein Thema von Chreaterdeluxe in: Windows Forum — Scripting

Wenn man weder Kosten noch Mühen scheut, geht alles. Du könntest z.B. im Hintergrund einen Prozess laufen lassen, der auf Outlook zugreift und die von Dir gewünschten Bedingungen prüft und wenn diese erfüllt sind, die von Dir gewünschte Aktion starten. Outlook selbst, kann meines Wissens nur auf Outlook-interne "Resourcen" zugreifen. -

Aus Outlook eine bat ausführen bei Maileingang

BOfH_666 antwortete auf ein Thema von Chreaterdeluxe in: Windows Forum — Scripting

Wenn ich Dich richtig verstanden habe - mit eingebauten Mitteln soviel ich weiß nicht, nein. -

PC Netzwerkabfrage mit Poweshell

BOfH_666 antwortete auf ein Thema von la-kro in: Windows Forum — Scripting

Bitte nicht immer wieder alles komplett zitieren! Was funktioniert nicht, welche Variablen sind leer? Bitte im Hinterkopf behalten: Wir können Deinen Bildschirm nicht sehen und auch Deine Gedanken (leider) nicht lesen. -

PC Netzwerkabfrage mit Poweshell

BOfH_666 antwortete auf ein Thema von la-kro in: Windows Forum — Scripting

Noch ne Kleinigkeit: Wenn Du hier im Forum antwortest, musst Du nicht immer den kompletten Vor-Beitrag zitieren. Lösch doch bitte einfach alles aus dem Zitat raus, was nicht nötig ist ... im Zweifel das gesamte Zitat. Das macht Deine Antworten leichter lesbar. Danke schon mal. -

PC Netzwerkabfrage mit Poweshell

BOfH_666 antwortete auf ein Thema von la-kro in: Windows Forum — Scripting

Hmmmm ... ich bin jetzt auch nicht der XML-Profi ... vielleicht kommt hier noch ein anderer Kollege und kann das lösen ... ich schau mir das später nochmal an .... Edit: Ich weiß schon, warum ich immer Kopfschmerzen kriege, wenn ich mich mit XML beschäftigen muss ... das ist einfach nicht Admin-Hirne gemacht ... ... aber wenn man dann erstmal wieder weiß, wie's geht, geht's wieder ne Weile. [XML]$a = get-content c:/hosts.xml $a.hosts.valueservers.valueserver.host $IPListe = $a.hosts.valueservers.valueserver.host.GetEnumerator().address foreach ($IP in $IPListe) { if (Test-Connection -ComputerName $IP -Count 1 -Quiet) { Write-Verbose "Information of $IP" $CS = Get-WmiObject -Class Win32_ComputerSystem -ComputerName $IP $IP = Get-WmiObject -Class Win32_NetworkAdapterConfiguration -Filter IPEnabled=TRUE –ComputerName $IP $OS = Get-WmiObject -Class win32_Operatingsystem -ComputerName $IP $Mon = Get-WmiObject -Class wmimonitorid -ComputerName $IP -Namespace root\wmi | ForEach-Object { ($_.SerialnumberID | foreach-object { [char]$_ }) -join '' } $BIOS = Get-WmiObject -Class Win32_BIOS -ComputerName $IP $reg = [Microsoft.Win32.RegistryKey]::OpenRemoteBaseKey('LocalMachine', $IP) $regkey = $reg.OpenSubkey("SOFTWARE\Microsoft\Windows\CurrentVersion\Uninstall") $prog = foreach ($SubKeyName in $regkey.GetSubKeyNames()) { $SubKey = $reg.OpenSubkey("SOFTWARE\Microsoft\Windows\CurrentVersion\Uninstall\$SubKeyName") $SubKey.GetValue("DisplayName") } [PSCustomObject]@{ ComputerName = $Cs.Name Model = $CS.Model SerialNumber = $BIOS.SerialNumber "Monitor Serial" = $Mon "OS Version" = $OS.caption "OS 32/64bit" = $OS.Osarchitecture IPAddress = $IP.IPAddress Gateway = $IP.DefaultGateway "NWcard index" = $IP.Index Framework = $prog } } } Ich weiß ja nicht, warum Du die ganzen UnInstall-Keys aus der Registry auslesen möchtest, aber es könnte sein, dass da deutlich mehr ausgelesen wird als Du erwartest. Auf einem normalen System kommt da gern mal Einiges zusammen. Und Du liest im Zweifel nur den 64- oder 32-bit-Schlüssel aus - je nach Zielsystem. Na dann probier mal, ob das so läuft. Und Ubrigens: Was benutzt Du als Code-Editor? Meine DRINGENDE Empfehlung wäre, VSCode und die ganzen Hilfen zu benutzen, die VSCode mitbringt. Das würde die Qualität und Lesbarkeit Deines Codes deutlich verbessern, denke ich. -

PC Netzwerkabfrage mit Poweshell

BOfH_666 antwortete auf ein Thema von la-kro in: Windows Forum — Scripting

Du versuchst die XML mit dem Pfad c:/hosts.xml einzulesen ... funktioniert das? Ich würde nur zur Sicherheit einen Backslash benutzen. Und Deine XML ist falsch. Die Werte müssen in den Tags stehen, nicht in den Namen/Beschreibungen ... ich hab das mal angepasst und hier angehängt. Dann sollte es auch $PC sein und nicht $PC.Address. ... 'kannst Du dann so überprüfen ... foreach ($pc in $a.hosts.valueservers.valueserver.host){ "Adresse: '$($pc)'" } hosts.xml -

PC Netzwerkabfrage mit Poweshell

BOfH_666 antwortete auf ein Thema von la-kro in: Windows Forum — Scripting

Was für eine ketzerische Frage .... !!! .... das ist keine Mühe, das ist ein Vergnügen!!! Was jetzt? Magst Du uns die XML zeigen oder stellst Du auf CSV um oder noch ganz was anderes? Du kannst die Registry auch remote abfragen. Dafür musst Du dann aber Invoke-Command benutzen, weil Get-ItemProperty selbst nicht remoting-fähig ist. -

PC Netzwerkabfrage mit Poweshell

BOfH_666 antwortete auf ein Thema von la-kro in: Windows Forum — Scripting

Ich leiste mir den Luxus Windows 7 und Powershell vor Version 5.1 nicht mehr zu supporten. Ohne Deine XML-Datei zu sehen, können wir dazu schwerlich was Intelligentes beitragen. Eine CSV-Datei wäre aber vermutlich deutlich einfacher zu handhaben. Diese Zeile fragt den lokalen PC ab, auf dem das Script läuft ... und das wieder und wieder bei jedem Schleifendurchlauf. -

PC Netzwerkabfrage mit Poweshell

BOfH_666 antwortete auf ein Thema von la-kro in: Windows Forum — Scripting

Ach Gottchen .... Du Ärmster ... ich werde Dich in meine Abend-Gebete einschließen. -

PC Netzwerkabfrage mit Poweshell

BOfH_666 antwortete auf ein Thema von la-kro in: Windows Forum — Scripting

Ich hätt' ja wieder einfach ein Upgrade auf Windows 10 empfohlen. Da ist die 5.1 sowieso schon mit dabei. Alles andere verlängert doch nur das Leiden. Hat einer von Euch noch Kunden, die wirklich noch Windows 8.1 im Einsatz haben? -

PC Netzwerkabfrage mit Poweshell

BOfH_666 antwortete auf ein Thema von la-kro in: Windows Forum — Scripting

Die solltest Du aber DRINGENDS in Rente schicken. Du hast also noch Windows 7 im Einsatz. Das solltest Du auch DRINGENDS in Rente schicken. Auf den Clients, die Du per WMI/CIM abfragen möchtest, muss übrigens nicht unbedingt eine aktuelle Powershell laufen. Die Abfragen laufen ja eben über WMI/CIM und nicht über Powershell. -

PC Netzwerkabfrage mit Poweshell

BOfH_666 antwortete auf ein Thema von la-kro in: Windows Forum — Scripting

Hmmm ... ich kann mich natürlich auch irren (ich tue das ziemlich häufig), aber ist es für einen Anfänger nicht erstmal einfacher, die Befehle "ganz normal" - also sequenziell abzuarbeiten? ... zumal für Foreach-Object -Parallel auch Powershell 7 nötig ist, was noch nicht jeder nutzt. ... und hier würd ich auch eher ein Export-Csv empfehlen. Wenn's schon mal strukturierte Daten sind .... -

PC Netzwerkabfrage mit Poweshell

BOfH_666 antwortete auf ein Thema von la-kro in: Windows Forum — Scripting

Hallo la-kro, Willkommen im MCSE-Board. Ich habe Dir mal ein Gerüst gebaut und 2 Deiner Abfragen integriert. Die restlichen kannst Du Dir - analog zu den beiden die Du unten siehst - allein einbauen. (Wenn nicht - einfach wieder melden! ) $pcs = Get-Content C:\pc.txt foreach ($ComputerName in $pcs) { if (Test-Connection -ComputerName $ComputerName -Count 1 -Quiet) { $CimSession = New-CimSession -ComputerName $ComputerName $CS = Get-CimInstance -ClassName Win32_ComputerSystem -CimSession $CimSession $BIOS = Get-CimInstance -ClassName Win32_BIOS -CimSession $CimSession [PSCustomObject]@{ ComputerName = $ComputerName Model = $CS.Model SerialNumber = $BIOS.SerialNumber } } } -

Powershell Dateien umbennenen mit variablen aus Tabelle

BOfH_666 antwortete auf ein Thema von Eledris in: Windows Forum — Scripting

Wow ... Respekt. Das bekommen nicht viele Anfänger so flott hin. ... und danke für's Teilen. Uuiiii .... hat da einer Blut geleckt? ... super ... immer gern. -

Üblicherweise lautet die Empfehlung bei Laptops, die ´vom Laptop-Hersteller angepassten Versionen der Grafikkartentreiber zu benutzen. Die Treiber des Grafikkartenchipsatzherstellers sind normalerweise für nur Desktop-Chipsätze geeignet.

-

Du hast 'n Grafikkartentreiber installiert und hast jetzt Probleme mit der Grafikausgabe. Hmmm ... neeeee ... das kann damit nich zusammenhängen.

-

Siehste - der Olaf hat eben doch keine Ahnung. Ich war davon ausgegangen, dass der Business Basic der E1 ist, da ich direkt mit E1 bezeichnete Pläne gar nicht gefunden hatte - ich Dussel.

-

Nicht verwendete Homelaufwerke finden

BOfH_666 antwortete auf ein Thema von StefanWe in: Windows Forum — Scripting

Ich würde auch eher die Methode von Jan empfehlen. Wenn Du Anwender hast, die ihr Home-Laufwerk so nutzen wie ich, löschst Du vielleicht Home-Laufwerke von Nutzern, die noch da sind. Unabhängig davon solltet ihr vielleicht überlegen, euren Joiner-Leaver-Prozess zu verbessern, um erst gar nicht in eine solche Situation zu kommen. -

Powershell Dateien umbennenen mit variablen aus Tabelle

BOfH_666 antwortete auf ein Thema von Eledris in: Windows Forum — Scripting

ELE, willkommen im MCSE-Board. Die Schleife ist schon mal ne gute Idee .... Deine Excel-Liste ist hoffentlich eine CSV-Datei. Wenn nicht, wäre es hilfreich, wenn Du sie in eine CSV-Datei umwandlest. Damit kann Powershell ganz problemlos umgehen. Für den Anfang solltest Du Dir die cmdlets Import-Csv, Forach-Object und die Hilfe für about_if und vielleicht about_foreach, about_comparison_operators und about_split. Du solltest immer die komplette HIlfe lesen - inklusive der Beispiele - um zu lernen, wie man die cmdlets benutzt. -

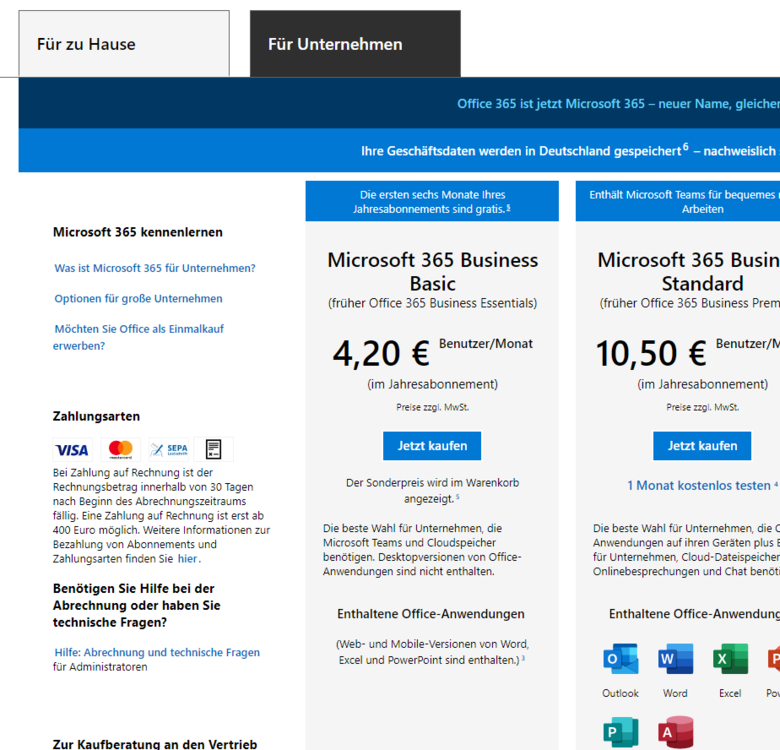

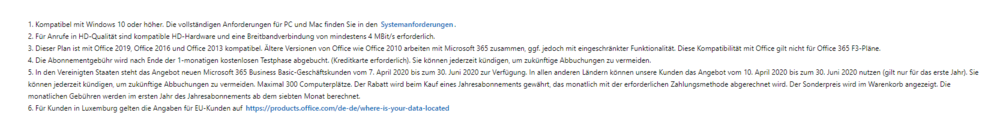

Entweder 's hilft oder ich oute mich jetzt als *** ... egal ... Ich hab grad mal danach gesucht ... bin mit meinem Firmen-Account bei MS angemeldet und schau mir die Angebote für Microsoft 365 an - Produkte -> Business-Angebot -> Pläne und Preise. Da gibt's dann "Microsoft 365 Business Basic (früher Office 365 Business Essentials)" und im Titel der Info-Box steht: "Die ersten sechs Monate Ihres Jahresabonnements sind gratis.". Ich verstehe das so, dass dafür kein Promo-Code gebraucht wird .... oder? .... oder ist das nicht die E1? Hier mal noch die Screenshots dazu: ... und hier noch die "Fußnoten" dazu: ... und hier die 5 als Text: 5. In den Vereinigten Staaten steht das Angebot neuen Microsoft 365 Business Basic-Geschäftskunden vom 7. April 2020 bis zum 30. Juni 2020 zur Verfügung. In allen anderen Ländern können unsere Kunden das Angebot vom 10. April 2020 bis zum 30. Juni 2020 nutzen (gilt nur für das erste Jahr). Sie können jederzeit kündigen, um zukünftige Abbuchungen zu vermeiden. Maximal 300 Computerplätze. Der Rabatt wird beim Kauf eines Jahresabonnements gewährt, das monatlich mit der erforderlichen Zahlungsmethode abgerechnet wird. Der Sonderpreis wird im Warenkorb angezeigt. Die monatlichen Gebühren werden im ersten Jahr des Jahresabonnements ab dem siebten Monat berechnet.

-

OK. Und aus welchem guten Grund würdest Du das dann tun?

-

Selbst wenn das Datum 2029 wäre, gäbe es im Moment trotzdem keinen guten Grund zu wechseln ... das ist doch das was ich meine ... Du hast noch ca. 4,32857 Jahre Zeit, Dir darüber Gedanken zu machen .... bis dahin kann uns alle noch Covid-20, 21, 22 oder 23 dahinraffen.

-

Na dann müssen wir aber Wetten abschließen und dann muss man auch was gewinnen können und das gehört dann aber nicht mehr ins Exchange-Forum.