-

Gesamte Inhalte

2.915 -

Registriert seit

-

Letzter Besuch

Alle erstellten Inhalte von cj_berlin

-

Update-Fehler von 2019 zu Windows Server 2025 26100.32230

cj_berlin antwortete auf ein Thema von bourbon in: Windows Server Forum

Moin, bitte genau welche Befehle, mit welchen Parametern und mit welchem Ergebnis, wenn dieser Post was anderes sein soll als nur Dampf ablassen. Ansonsten sagt meine Erfahrung, dass: im CBS.log einige sachdienlichen Hinweise zu finden sein werden bei dem Fehlercode auch das Inplace-Upgrade scheitern wird. -

Kerberos Armoring, Fehler bei Domain-Trust

cj_berlin antwortete auf ein Thema von mzahneissen in: Windows Forum — Security

Leider nicht wirklich... -

Basic ist wieder voll in - alle holen sich den neuen C64 und so...

-

-

Moin, von den neueren Büchern, das hier ist nicht schlecht: https://www.amazon.de/dp/B09MFY582N Das ist ein Klassiker, aber schon was älter: https://www.amazon.de/Active-Directory-Designing-Deploying-Running-ebook/dp/B00CBM1WES Wenn einer von denen für das Thema richtig brennen sollte, kann er sich mein Buch reinziehen

-

RDP-Verbindung funktioniert nicht mehr nach Windows Server Update auf 2025

cj_berlin antwortete auf ein Thema von RSAP in: Windows Server Forum

Moin, kannst Du bitte den Unterschied zwischen "Terminalserver" und "Clientserver" kurz erläutern. Zweiteres ist mir kein Begriff. Und vielleicht verlierst Du zwei-drei Worte zu der Umgebung (Broker mit/ohne HA, wie viele Collections, was für Clients usw.) -

W11 - Edge fragt unerwartet ob whatsapp.com, youtube.com... angeheftet werden soll...

cj_berlin antwortete auf ein Thema von wznutzer in: Windows 11 Forum

Ich hoffe, dass dies in die 30% KI-generierten Code fällt. Kann mir nicht vorstellen, was ich tun würde, wenn ich als Dev den Job kriege, so einen Scheißdreck zu programmieren... Oder nutzt das jemand wirklich, und ich verpasse die einmalige Chance, meinen Alltag zu optimieren? -

Rechner geht nicht immer aus beim Herunterfahren - Ideen?

cj_berlin antwortete auf ein Thema von cj_berlin in: Windows Server Forum

Der erste Test war positiv, aber das Phänomen ist leider nicht beliebig reproduzierbar. Ich werde es beobachten und das Ergebnis melden. -

Rechner geht nicht immer aus beim Herunterfahren - Ideen?

cj_berlin antwortete auf ein Thema von cj_berlin in: Windows Server Forum

Moin, nein, das mit dem Deaktivieren des Power Managements hatte ich noch nicht versucht, danke für den Hinweis. BIOS ist aktuell. -

Rechner geht nicht immer aus beim Herunterfahren - Ideen?

cj_berlin antwortete auf ein Thema von cj_berlin in: Windows Server Forum

Hmmm, bei den heutigen RAM-Preisen mal eben zwei 48GB DIMMs tauschen, da würge ich das Teil lieber ab, oder skripte Reboot+Shutdown. Garantie ist schwierig, weil die DIMMs nicht offiziell supported sind (es gibt nur ein einziges supportetes Modell mit 48GB, und das habe ich aufs Verrecken nicht kaufbar finden können). -

Rechner geht nicht immer aus beim Herunterfahren - Ideen?

cj_berlin hat einem Thema erstellt in: Windows Server Forum

Hallo zusammen, ich habe hier so einen NUC von ASUS, auf dem Server 2022 als Hyper-V läuft. Tatsächlich habe ich davon zwei, der andere verhält sich aber normal. Die BIOS-Einstellungen bei den beiden sind identisch, soweit ich es beurteilen kann, die BIOS-Version auch. Der erste verhielt sich auch normal, bis irgendwann ein DIMM kaputt war und getauscht werden musste. Seitdem gibt es folgendes - NICHT deterministisches - Verhalten: wenn ich den Rechner hochfahre, ein bisschen im Leerlauf lasse und dann herunterfahre, geht er ganz normal aus wenn ich aber VMs starte (dieses Lab lastet die Maschine so ca. 50% aus), diese laufen lasse und anschließend alle beende (oder hart ausschalte), fährt der Rechner zwar insofern herunter, dass nichts mehr reagiert und auch der Bildschirm aus ist, er schaltet sich aber nicht aus und muss "erwürgt" werden. Aber nicht immer - manchmal klappt's auch. Aber eher selten. arbeite ich mit VMs, boote den Host dann neu und fahre ihn danach herunter, geht er wieder ordnungsgemäß aus. Jegliche Ideen zur Diagnose und Behebung sind willkommen, wie immer -

Benutzerkontensteuerung - Erhöhte Rechte über Remote Steuerung

cj_berlin antwortete auf ein Thema von bigthe in: Windows 11 Forum

Also Du siehst über ICA/HDX die Maske gar nicht, wo Du den Admin eingeben sollst? Ich würde sagen, wenn es ÜBERHAUPT funktionieren soll, dann brauchst Du PropmtOnSecureDesktop=0 und nicht 1, denn 1 ist ja genau das, was Du auch so erlebst... Die Regkeys, die Du da beschreibst, sind auch nichts neues, sondern das ganz normale UAC. -

Import von großen PST-Dateien in M365

cj_berlin antwortete auf ein Thema von guybrush in: MS Exchange Forum

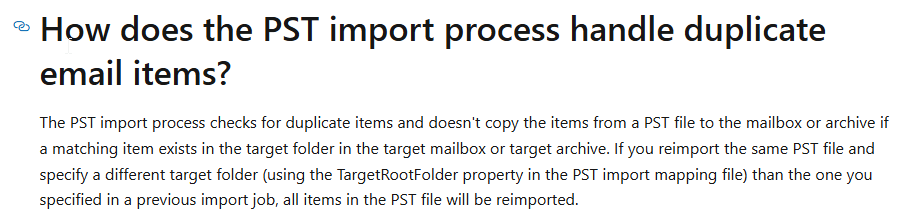

Aber mit 40GB und einem Postfach ist die Grenze für Festplattenversand noch lange nicht erreicht. Duplikate: -

DFS und Zugriff durch Computer

cj_berlin antwortete auf ein Thema von dataKEKS in: Windows Server Forum

Moin, ist es ein domain-basiertes DFS-N? Dann müsste der Pfad ja lauten \\domae.ne\dfs\msi ... -

Weitere Schnittstelle für das Administrationsnetzwerk

cj_berlin antwortete auf ein Thema von RalphT in: Windows Server Forum

Moin, ein zweiter Default Gateway ist Mist und unter Windows auch nicht supported (obwohl technisch möglich). Allerdings kann man spezifische Gateways eintragen (route add -p), so dass der Traffic von und zu den Management PCs über die richtige Schnittstelle läuft. Was unter Windows allerdings nicht ohne weiteres geht, ist, spezifische Protokolle nur auf spezifische Adressen/Schnittstellen zu binden (Ausnahmen wie DNS bestätigen die Regel). Da musst Du mit der Windows Firewall dafür sorgen, dass RDP, VNC, WMI, WSMan, WinRM usw. nur über die Management-Schnittstelle erreichbar sind. Ferner musst Du dafür sorgen, dass die Management-Interfaces sich nicht in das zentrale DNS eintragen. Das bedeutet im Umkehrschluss, dass Du im Management-Netzwerk ein komplett separates DNS brauchst, damit Kerberos weiterhin funktioniert. Alles in allem ein interessanter Ansatz. hört sich aber nach jemandem an, der im Firewall-Zeitalter sozialisiert wurde und versucht, Sicherheit primär über Verkehrsbeziehungen zu regeln... -

Um- und Weiterleitungen serverseitig für bestimmte Absender deaktivieren?

cj_berlin antwortete auf ein Thema von Garant in: MS Exchange Forum

Moin, Du meinst, wenn der Besitzer eine Regel aktiv hat? Du kannst sie als Admin anpassen, siehe Set-InboxRule. Aber Du kannst Exchange m W. nicht per Transport Rule anweisen, Inbox Rules nicht zu verarbeiten... -

Probleme mit LDAP(S)

cj_berlin antwortete auf ein Thema von Emmermacher in: Windows Forum — LAN & WAN

Das wäre dann wohl auch die Ursache, oder? Ist in ARPGuard denn auch nur die IP-Adresse eingetragen? -

Probleme mit LDAP(S)

cj_berlin antwortete auf ein Thema von Emmermacher in: Windows Forum — LAN & WAN

Moin, 636 ist immer offen, auch wenn noch gar kein Server-Zertifikat installiert ist. Vielleicht gibt es ein Problem mit der Zertifikatsauswahl, so dass kein Zertifikat gebunden werden kann? Darüber müsstest Du aber Event Log-Einträge beim Start des NTDS-Dienstes sehen... Hier ein bisschen Lektüre: AwakeCoding ☀️💻 | Active Directory LDAPS certificate selection deep dive -

Probleme mit LDAP(S)

cj_berlin antwortete auf ein Thema von Emmermacher in: Windows Forum — LAN & WAN

Moin, was sind denn die Probleme, die ihr habt? Lassen sie sich auch mit ldp.exe reproduzieren? Ich nehme an, dass LDAP(S) gegen Domain Controller versucht wird - welche Server-Version haben die? -

Tag 1, Minute ~35 meines PowerShell-Lehrgangs für Anfänger: "Denkt daran, jeden Code immer in der Umgebung zu testen, in der er später auch laufen soll." Das war zu PowerShell 3.0-Zeiten

-

Powershell Programmierumgebung für GUI

cj_berlin antwortete auf ein Thema von Peterzz in: Windows Forum — Scripting

Aber ansonsten, 90% der PowerShell-GUIs sind XAML und WPF. Visual Studio Express, ein paar Erklär-Videos, und Du bist bereit für den Kaninchenbau -

Kerberos Realm Mapping bei SPNs mit Port/Instanz

cj_berlin antwortete auf ein Thema von daabm in: Active Directory Forum

Moin, wollte gerade schreiben "und sowas auf den Freitag?", und dann fiel mir auf, dass ja noch gar nicht Freitag ist. Funktioniert es evtl. wenn man den ganzen FQDN in das Mapping aufnimmt und nicht nur die Domain? Ich bin mir gerade nicht sicher, ob das Mapping das Verhalten von DsMakeSpn beeinflusst oder erst durch die LSA angehängt wird. -

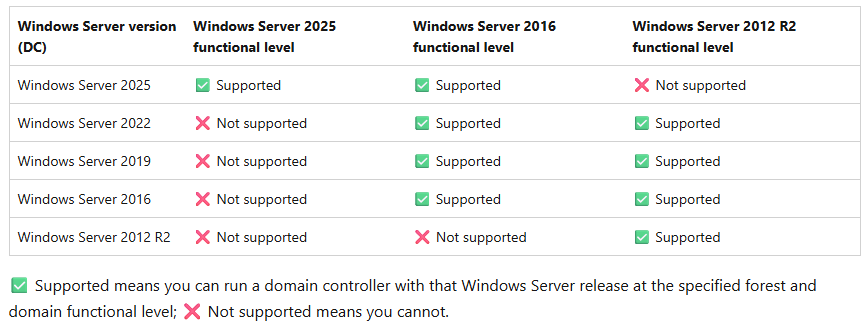

Moin, "unbekannt" bedeutet wohl, dass Du es mit einer Version von (was auch immer Du benutzt) abfragst, die älter ist als 2025. Frühere RSAT-Versionen kennen den FL 10 (=2025) tatsächlich nicht. "laut Microsoft" , also in der offiziellen Dokumentation (https://learn.microsoft.com/en-us/windows-server/identity/ad-ds/active-directory-functional-levels) <-- siehst Du, wie einfach das geht? sieht es so aus:

-

Virtual WinSrv2019 BlueScreen - inaccessible boot device

cj_berlin antwortete auf ein Thema von helpodbc in: Windows Server Forum

Je nach Format der virtuellen Platte könntest Du sie ggfls. sogar einfach in einer Windows-Instanz direkt mounten. -

Outlook Exchange archiviert Mails die in den Papierkorb gehen sollten

cj_berlin antwortete auf ein Thema von Haleh in: MS Exchange Forum

Moin, das ist sehr wohl ein Systemordner, in Outlook Mobile wäre das der Unterschied zwischen "swipe left" (Archiv) und "swipe right" (Papierkorb). @Haleh bist Du sicher, dass es nicht genau das ist?