-

Gesamte Inhalte

4.241 -

Registriert seit

-

Letzter Besuch

Alle erstellten Inhalte von WSUSPraxis

-

Script - Ordner liegt länger als 5 Minuten im Verzeichnis

WSUSPraxis antwortete auf ein Thema von WSUSPraxis in: Windows Forum — Scripting

Ich wollte nochmals Danke sagen ! Du hast mir sehr geholfen ! -

Script - Ordner liegt länger als 5 Minuten im Verzeichnis

WSUSPraxis antwortete auf ein Thema von WSUSPraxis in: Windows Forum — Scripting

Hallo und Abend, danke Dir ! Das war mein Fehler ! $_.psIsContainer -eq $false -

Script - Ordner liegt länger als 5 Minuten im Verzeichnis

WSUSPraxis hat einem Thema erstellt in: Windows Forum — Scripting

Hallo und Guten Morgen, leider sehe ich Heute Morgen den Wald vor lauter Bäumen nicht und komme nicht wirklich weiter oder stehe völlig auf dem Schlauch. Eine Applikation schreibt in einen lokalen Ordner Dateien und erstellt auch Ordner mit Inhalt. Die Dateien haben verschiedene Datei Endungen. Die Ordner / Folder werden minütlich von der Applikation erstellt und in F:\foldername\" geschrieben. Liegt ein Order / Folder länger als 5 Minuten soll per Powershell Script eine Warnung ausgegeben werden "Found old Files" ! Das würde auch funktionieren wenn in den Ordnern / Foldern welche die Applikation erstellt, nicht auch Files vorhanden wären, welche älter als 5 Minuten sind. Diese sind teilweise viel älter - sind aber zwingend notwendig. $fullPath = "F:\foldername\" $numdays = 0 $numhours = 0 $nummins = 5 function ShowOldFiles($path, $days, $hours, $mins) { $BaseDate = (Get-Date).AddDays(-$days).AddHours(-$hours).AddMinutes(-$mins) if (get-childitem $path -include *.* -recurse | where {$_.LastWriteTime -lt $BaseDate -and $_.psIsContainer -eq $false}) { write-host "Found old files" -Fore Red } } ShowOldFiles $fullPath $numdays $numhours $nummins Die Ordner selbst welche erzeugt werden heißen immer spool_willkürliche Nummer und nur diese sollen überwacht werden. Jetzt zu meinem Problem: Wenn ich hier -include *.* -recurse etwas ändere läuft das Script nicht mehr oder es werden wieder die älteren Dateien aus den Ordnern gefunden. Mit -filter usw... habe ich es auch schon probiert ! -

Hallo und Guten Morgen, ich bin auf jeden Fall dabei. Viele Grüße Arnd

-

E-Mail von extern an E-Mail Verteilerliste mit externem Kontakt

WSUSPraxis antwortete auf ein Thema von BpDk in: MS Exchange Forum

Hallo und Guten BpDk, das Problem ist leider bekannt und wird zur Zeit von Microsoft so für Office 365 nicht unterstützt. Du musst Dir selbst eine andere Lösung bauen oder den Prozess umstellen. Viele Grüße Arnd -

Modernisierung eines Server-Netzwerk von Windows 2012 R2 auf Windows 2019 - Eine Frage

WSUSPraxis antwortete auf ein Thema von magicpeter in: Virtualisierung

Hallo Peter, und magst Du es so umsetzen ? Viele Grüße Arnd -

Hallo Norbert, einer Software welche Made in Germany ist, welche BSI und ISO zertifiziert ist usw... Der Vertraue ich Persönlich erst einmal und dem Anbieter vertraue ich erst einmal ! Viele Grüße Arnd

-

Zugriff haben, Zugriff haben können, Zugriff sich verschaffen usw... Ist nach meiner Ansicht etwas anders, als die Mails laufen über ein Cloudsystem ?

-

Also ich würde jetzt mal sagen ! Die Aussage stimmt nicht.

-

Das wäre auch genau meine Empfehlung. Viele Grüße Arnd

-

Probleme mit Distribution Groups bei Exchange 2016

WSUSPraxis antwortete auf ein Thema von MSExchangeAdmin in: MS Exchange Forum

Wir in einer Exchange Umgebung eine Universelle E-Mail-Verteilergruppe angelegt, so ist diese Gruppe nicht von extern zu erreichen und kann nur als interne Verteilergruppe verwendet werden. Dabei spielt es auch keine Rolle, ob diese Verteilergruppe über eine offizielle externe Email-Adresse verfügt oder eben nicht. Eine frisch angelegte Verteilergruppe funktioniert immer nur intern. Soll diese auch als öffentliche Verteilergruppe (die hinterlegte Email von außen erreichbar sein) dienen, so muss dies in den Einstellungen am Exchange Server hinterlegt werden. -

Fehler bei AD-Zugriff bei Exchange Migration

WSUSPraxis antwortete auf ein Thema von ExchangeAdmin in: MS Exchange Forum

Mich würde interessieren was Du jetzt genau wie gemacht hast ? -

Warum sollte das Clearinghouse das auch tun ?

-

Neuer Server für Terminal/RDS mit Zugriff auf Lexware, aber welchen? (5 User)

WSUSPraxis antwortete auf ein Thema von Nettzwerg in: Windows Server Forum

Terminalserver / Remotedesktop / Virtuelle Maschinen / VPN Die Konstellationen Terminalserver, Remotedesktop bzw. virtuelle Maschinen werden derzeit nicht offiziell von Lexware unterstützt, also nicht supportet. In der Praxis laufen die Programme in der Regel aber problemlos. VPN Verbindungen zwischen verschiedenen Standorten und darüber erstellte Client-Server-Umgebungen sind technisch natürlich möglich. In der Praxis werdet Ihr damit aber sehr wenig bis gar keinen Spass bei der Arbeit haben. Ich kann daher eine solche Konstellation nicht empfehlen, offiziell unterstützt wird es zudem auch nicht. Das sagt der Lexware Support bei Lex Warenwirtschaft..... Bedeutet - Das Ihr bei Problemen, welche auch mit Lexware zu tun haben und nicht an der / mit der RDS Umgebung zu tun haben kein Support bekommt. Daher kann ich Euch nur dazu raten, Euch eine WAWI zu suchen, welche Terminal Server tauglich ist oder doch eine Cloud Variante. Was spricht geben SaaS Lösung ? Ich kann Euch aber wenig Empfehlen, da ich Eure Anforderungen nicht kenne. Viele Grüße Arnd -

Neuer Server für Terminal/RDS mit Zugriff auf Lexware, aber welchen? (5 User)

WSUSPraxis antwortete auf ein Thema von Nettzwerg in: Windows Server Forum

Hallo und schönen Mittag, um welches Lexware Produkt handelt es sich ? Nicht alle / sehr viele sind nicht für den Betrieb auf Terminal Server / RDS Umgebungen freigegeben. Viele Grüße Arnd -

Zugriff für Externe Dienstleister

WSUSPraxis antwortete auf ein Thema von Rocknar in: Windows Server Forum

Hallo und Mittag, wenn möglich machen wir das bei unseren Kunden: RDSH über RD Gateway mit Token, von dort auf Server / Jumphosts / PAWs / Web-Oberflächen + Monitoring und bei Bedarf auch werden die Zeiten eingeschränkt wo zugegriffen werden darf. Viele Grüße Arnd -

Azure - Win Server 2019 - Framework 3.5

WSUSPraxis antwortete auf ein Thema von MercedesCR7 in: MS Azure Forum

Klasse - Dann passt das Ja ! -

Azure - Win Server 2019 - Framework 3.5

WSUSPraxis antwortete auf ein Thema von MercedesCR7 in: MS Azure Forum

Hallo und Mittag, mit der passenden ISO geht das Problemlos. Viele Grüße Arnd -

InnerException=> SourceAnchor attribute has changed.

WSUSPraxis hat einem Thema erstellt in: MS Azure Forum

Hallo und schönen Abend, Ausgangssituation: Lokales AD - AAD Connect mit msDS-ConsistencyGuid als SourceAnchor - Sync nach Azure AD Durch einen fehlerhaften User Restore haben 3 User das Problem, dass Sie sich nicht mehr am Azure AD / Office 365 anmelden können. Folgende Meldung befindet sich im AAD Connect: => Der SourceAnchor Wert unterscheidet sich im Alten und Neuen Wert Leider habe ich dazu nichts gefunden wie die User / Werte wieder gesynct werden können ? Ich würde mich über Eure Hilfe sehr freuen. Viele Grüße und schönen Abend -

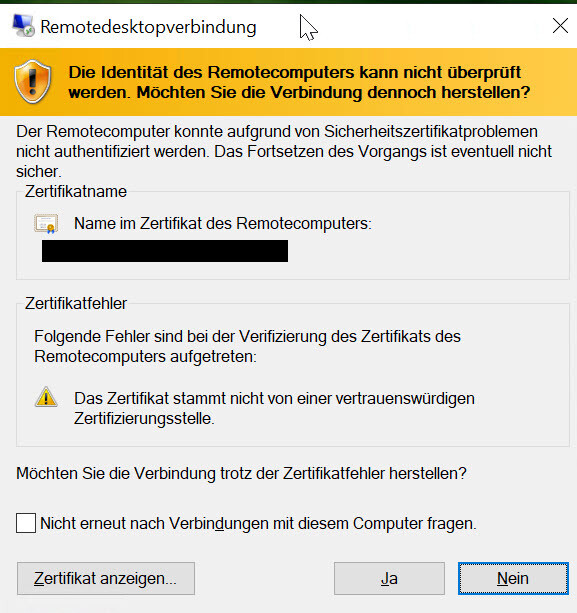

RDS Farm Windows Server 2019 SHA256

WSUSPraxis antwortete auf ein Thema von WSUSPraxis in: Windows Server Forum

Hallo Evgenij, danke Dir für den Einsatz. Okay jetzt wird es extrem Verrückt ! Wenn ich mir das RDP File über RDWEB runterlade und verwende - Dann kommt keine Warnung ? Wo liegt mein Denkfehler ? Viele Grüße Arnd -

RDS Farm Windows Server 2019 SHA256

WSUSPraxis antwortete auf ein Thema von WSUSPraxis in: Windows Server Forum

Hallo und Guten Morgen, das es ein Zertifikat von einer Offiziellen PKI ist und die Kette installiert wurde - Nein - Die Meldung kommt vom Internen Self Sign Zertifikat, welches nicht verwendet werden sollte. Viele Grüße Arnd Hallo und Guten Morgen, Habe ich gerade nochmals gemacht. Session Host aus Collection genommen. Vererbung von GPO´s abgeschalten für die OU. Session Host wieder rein genommen. Leider das gleiche Problem. Es wird immer das Self Sign Zertifikat des Session Host verwendet. Viele Grüße Arnd -

RDS Farm Windows Server 2019 SHA256

WSUSPraxis antwortete auf ein Thema von WSUSPraxis in: Windows Server Forum

Hallo und Guten Morgen, danke für deine Nachricht. Ich würde den Aufbau / Vorgehen nochmals genauer Beschreiben. => Wildcard Zertifikat wurde im Deploymend allen Rollen gleich zugewiesen und ist als Trusted gekennzeichnet => RDS Zugriff erfolgt üb er Collection Name webwork.testdomain.de => Eingabe Benutzername und Kennwort => Keine Zertifikatswarung => OK => Verbindung wird Hergestellt Dann erscheint die Zertifikatsmeldung. Hier dann jeweils das Zertifikat des jeweiligen Session Host. Viele Grüße Arnd -

RDS Farm Windows Server 2019 SHA256

WSUSPraxis antwortete auf ein Thema von WSUSPraxis in: Windows Server Forum

Hallo Thomas, danke Dir trotzdem ! Leider komme ich garnicht weiter.. Viele Grüße Arnd -

RDS Farm Windows Server 2019 SHA256

WSUSPraxis antwortete auf ein Thema von WSUSPraxis in: Windows Server Forum

Hallo und Mahlzeit, Danke Dir ! Ja so habe ich es konfiguriert. Aber so wird nach meiner Ansicht nicht den Session Host das RDS Listener Zertifikat zugewiesen ? Viele Grüße Arnd -

RDS Farm Windows Server 2019 SHA256

WSUSPraxis antwortete auf ein Thema von WSUSPraxis in: Windows Server Forum

Hallo und Guten Morgen, ich habe die Nacht geforscht und alles probiert ! Doch leider habe ich nichts dazu gefunden. Viele Grüße Arnd