Zebbi

Members-

Gesamte Inhalte

136 -

Registriert seit

-

Letzter Besuch

Alle erstellten Inhalte von Zebbi

-

HAllo, ich arbeite mich gerade in das Thema VLANa ein. Nun haben wir leider nur die überall im Netz verschrienen Netgear Switche bekommen und Netgear scheint einiges anders zu machen als der Rest, was das Verständnis nicht gerade fördert. :( Wäre toll wenn Ihr mir da kurz auf die Sprünge helfen könntet. * Wenn ich ein Port auf Untagged VLAN 100 setze ist der Port im VLAN 100, das Gerät bemerkt nichts weiter davon und braucht gar keine VLANS unterstützen, alle Pakete landen einfach im VLAN 100. Richtig? *Setze ich einen Port NUR auf Tagged VLAN 200 kennt der Port nur das VLAN 200 und Pakete die auf dem Port ankommen, müssen mit VLAN 200 getagged sein um nicht verworfen zu werden. Es sei denn, ich hab den Port auch in einem ungetagged VLAN (default 1), dann KANN er VLAN 200 oder aber untagged um im VLAN 1 zu landen. Richtig? *PVID (bei Netgear): Netgear eigenart; eigentlich das gleiche wie Untagged, aber gilt auch für Pakete die aus einem Trunk stammen, der über den Port läuft. So wirklich verstanden hab ich es aber nicht.... *Ein Port soll allgemein nur in einem VLAN untagged sein, Netgear erlaubt aber mehrere untagged VLANs pro Port. Hängt der eine Port dann wirklich in allen VLANs? Falls ja, kann ich meiner Netzwerkkarte dann einfach eine IP je VLAN geben und bin dann in allen VLANs? Wäre super wenn Ihr mir auf dioe Sprünge helfen könntet.

-

Gekaufte 2008er Lizenz und Hyper-V 2016?

Zebbi antwortete auf ein Thema von Zebbi in: Microsoft Lizenzen

Danke für den Tip mit Windows 10, die Erfahrung hatte ich mit meinem Testaufbau auch schon gemacht. Mit der GF zu reden ist eine Gehaltsklasse über mir, ich bin ja nur dummer Techniker der immer gleich den WorstCase anführt und froh wenn mein Cheff meine Bedenken überhaupt versteht. Vieles wird einfach so entschlossen weil jemand das "so und nicht anders" haben will. Wie schon gesagt wurde, da hilft nur es knallen zu lassen. ;) Finanzierung an sich ist kein Problem, eher die Einsicht das überhaupt Geld ausgegeben werden muss, denn "es läuft doch". Die eigentlich Frage ist aber gelößt, daher vielen Dank für alle Antworten und nun geht raus und genießt das Wetter! :) -

Gekaufte 2008er Lizenz und Hyper-V 2016?

Zebbi antwortete auf ein Thema von Zebbi in: Microsoft Lizenzen

Wow, mit so viel Antworten hab ich gar nicht mehr gerechnet. :) Die jetzige Warenwitschaft ist auf Terminalserver ausgelegt und lizensiert und dabei SEHR RAM-Lastig womit die alte Hardware fast am Limit ist, da machts es also keinen Sinn mehrere dieser VMs auf einem Gast laufen zu lassen bevor nicht auch die Hardware getauscht wird. Die Terminalserver sind ein vor Ewigkeiten völlig falsch angegangenes Konzept, da das Warenwirtschafssystem, welches sich auf ein sehr festes System aus Macadressen, festen Sofwareabhängigkeiten und -Versionen (OS, Office,...) und vielen weiteren Schweinerein stützt, da ist leider nichts dran zu drehen, da hilft nur die Warenwirtschaft auszutauschen und das ist nicht gewollt. Daher soll diese "bald" zumindest auf eine neue Version gebracht werden, bei der die meißten Abhängigkeiten aufgebrochen werden, was dann auch ermöglicht neuere SW zu nutzen und das soll in dem Zuge mit angegangen werden. Einen sauberen Failover werde ich bis dahin wohl auf Grund dieser "Unschönheiten" auch nicht ohne manuelles nacharbeiten hinbekommen, aber das kann ich evtl. scripten und selbst wenn nicht, dürfte das manuell nur wenige Minuten dauern, was die Downtime schon auf das Warenwitschafssystem beschränken würde wo wir bisher einen mehrstündigen Totalausfall hatten. Leider kapieren die hier nicht das es nichts bringt nur Hardware ODER Software zu tauschen und dann wieder zu warten bis alles total veraltet ist bevor man den anderen Part tauscht. Daher werden MS-Lizenzen auch gebraucht gekauft, anstatt einen SA-Vertrag einzugehen. Wie gesagt, momentan sind sowohl Hardware, als auch Software total veraltet und beides bekomme ich nicht gleichzeitig neu und angesichts des Supportendes von 2008r2 und ewig langer Genehmigungsprozesse... :( Logisch wäre für die Gegebenheiten eigentlich ein Umzug in die Cloud was aber erstmall von der Geschäftsführung nicht gewollt ist. Ich werde nun also vorerst den kostenlosen 2016er-Hyper-V installieren und mich weiter mit MMC und powershell anfreunden müssen. ;) -

Gekaufte 2008er Lizenz und Hyper-V 2016?

Zebbi antwortete auf ein Thema von Zebbi in: Microsoft Lizenzen

Danke, das war wohl der Knoten im Kopf! :) Ja, das soll tatsächlich eine Produktivumgebung werden. Für nächstes Jahr ist der Software-Umstieg eingeplant aber bis dahin muss ich noch ein paar kleine Server aufsetzen, wohl wissend das ich die danach wohl als 2016er neu aufsetzen werde. Da ich aber kein zusätzliches Blech bekommen werde und die Downtime wie immer klein sein soll, möchte ich die trotzdem schon als VMs haben und das Blech dann nach und nach zum 2016er Fail-Over-Cluster machen und die Gäste dann in aller Ruhe migrieren. Wenn ich da jetzt schon den kostenlosen 2016er unterschieben kann und nicht über den 2008er gehen muss, ist es um so besser. :) Einer der 2016er-Cluster soll später mit 2-4 Hosts DataCenter Lizenzen bekommen, um möglichst viele kleine aber wichtige Gäste zu beherbergen (einen der DCs, Telefonanlage, Printserver, Fileserver ...) und dann endlich möglichst ausfallsicherer sein. Der Rest (hauptsächlich Terminalserver) plane ich ebenfalls als VM ein, sollen aber aus Performancegründen jeweils auf einem eigenen Host laufen, wobei ein zusätzlicher Hyper-V-Host als leere Reserve mitlaufen wird, einfach um Hardwareausfällen vorzubeugen ohne Engpässe zu bekommen. Die TS werden dann wohl unter der 2016 Std.-Lizenz laufen und die Host dementsprechend auf eine VM begrenzt. -

Gekaufte 2008er Lizenz und Hyper-V 2016?

Zebbi antwortete auf ein Thema von Zebbi in: Microsoft Lizenzen

Also mit der Kostenlosen Hyper-V 2016 OHNE GUI wäre das OK, aber sobald ich einen 2016 Server mit Hyper-V (also mit GUI) nehme (und den natürlich lizensiere) MUSS ich auch alle darunter mit 2016 lizensieren, obwohl ich 2008er Lizenzen hab und nur 2008 zum einsatz kommt? -

Gekaufte 2008er Lizenz und Hyper-V 2016?

Zebbi antwortete auf ein Thema von Zebbi in: Microsoft Lizenzen

Danke, also stimmt das mit dem "neuste Version bestimmt die Lizenz" nicht? Klar ist das nicht gerade optimal, aber besser als komplett auf Blech zu installieren. ;) Ich hatte vor einiger Zeit mal einen Testaufbau mit 2016-Hyper-V, da kam ich mit der powershell ganz gut klar und vieles kann man ja auch per MMC erledigen. ;) -

Hallo, ich hab da eine ungewöhnliche Lizenzkombination und hoffe das mir jemand sagen kann ob das OK wäre. Wir haben hier noch einige gekaufte und noch ungenutzte "Server 2008 R2 Standard" Lizenzen rumliegen, aber keine Software-Assurance-Verträge! Bisher haben wir keine Virtualisierung genutzt und bis wir auf 2016 umstellen wird noch etwas dauern, daher gibts erstmal keine neuen Lizenzen! Da mein Plan für später den Einsatz von Hyper-V 2016 beinhaltet, möchte ich jetzt gerne bei neuer Hardware schon mal einen Hyper-V installieren um die Produktivsysteme nicht mehr vom Blech abhängig zu haben. Auf dem Hyper-V muss ich dann leider erstmal die noch vorhandenen 2008er-Lizenzen für neue VMs nutzen. Der Hyper-V an sich ist ja kostenlos und 2008er-Lizenzen hab ich genug um jeder VM seine eigene Lizenz zu geben. Aber DARF ich dann auch den kostenlosen Hyper-V 2016 nutzen, oder muss ich den alten 2008er Hyper-V nutzen, wenn die Gäste mit einer 2008er Lizenz laufen? Hab ich beim Failover noch irgendwelche Lizenzbeschränkungen? Ich meine da mal was von "neuste Version bestimmt die Lizenz" gelesen zu haben... :(

-

Plattenlast Terminalserver - Wie schuldigen finden?

Zebbi antwortete auf ein Thema von Zebbi in: Windows Server Forum

Hallo nochmal, mittlerweile ist einiges an Zeit vergangen und ich hab ein paar Sachen geändert und wollte davon noch abschließend berichten. 50GB sind wirklich das hardcoded Maximum einer OST, danach versucht Office das zu reparieren, ob es wirklich irgendwann etwas bringt weiß ich nicht, nach zwei Tagen automatischer Reparatur an einer OST hab ich es abgebrochen. Bis ca. 4GB sind OSTs/PSTs auf Shares praktisch kein Problem, danach kommt es überproportional zu Fehlern. Ob das lokal besser ist weiß ich noch nicht, kommt für mich derzeit aber auch nicht in Frage da schnellere und größere lokale Platten bei den alten Kisten nicht unterstützt werden, eben sowenig eine direkte Anbindung ans Storage. Caching generell kann ich bei uns nicht abschalten, dann wird es aufgrund der geringen Internetanbindung unerträglich lahm. Deshalb hab ich, bei Testkandidaten per Registryeintrag, das Cachen von freigegeben Postfächern deaktiviert, somit sind diese freigegebenen Postfächer zwar sehr träge und der eine oder andere User am fluchen, aber die Größe der OSTs ist von Teils 50GB auf 10GB gesunken und das restliche Outlook damit sehr viel schneller und viel weniger Fehleranfällig. Nächster Schritt: Deaktivieren des Freigabencaches per GPO für Alle. Positive Nebeneffekte: 1.) Das Backup ist viel kleiner zumal OSTs bei dem Gedankengang komplett aus dem Backup rausgeflogen sind, da der Exchange separat gesichert wird. 2.) Die Platten-Fragmentierung ist stark gesunken, somit ist die Leistung allgemein etwas gestiegen. :) Eine Exchangseitige Mailarchivierungssoftware wird eingeführt, welche die Existenzberechtigung der PSTs beendet und die OSTs weiter verkleinern wird, da alte Mails per Regel heraus archiviert werden. Eine vernünfige Lastüberwachung die mir sagt welcher Job die Platte auslastet und ggf. automatisch den Job beendet oder dergleichen, hab ich leider noch immer nicht. :( -

Plattenlast Terminalserver - Wie schuldigen finden?

Zebbi antwortete auf ein Thema von Zebbi in: Windows Server Forum

Danke für die Antworten, OWA kommt leider nicht in Frage, unter anderem weil das Warenwirtschaftssystem direkt auf Outlook zugreift. Auf dem TS arbeiten ca. 40 Leute, quasi alles was nicht im AppData-Ordner oder auf dem Desktop landet wird per Ordnerumleitung auf den Fileserver geschoben (Ja, OST/PST im LAN ist nicht supportet, geht aber nicht anders in der Konstellation und problematisch sind ja gerade die LOKALEN OSTs.) Damit ist die Systemplatte derzeit 500GB groß und zu 2/3 voll. Der Prozessexplorer zeichnet ja leider auch nicht auf und Warnungen oder gar Scripte kann ich so auch nicht starten. :( -

Plattenlast Terminalserver - Wie schuldigen finden?

Zebbi antwortete auf ein Thema von Zebbi in: Windows Server Forum

Das hab ich natürlich schon probiert, aber an der Stelle hängt das System schon so stark, das es nicht mehr Hilft den Prozess zu killen, Outlook ist in dem Moment extrem hartnäckig. :( Ich kann ja nicht einmal erkennen welches Outlook es ist, das war bisher eher ein austesten der üblichen Verdächtigen. -

Plattenlast Terminalserver - Wie schuldigen finden?

Zebbi antwortete auf ein Thema von Zebbi in: Windows Server Forum

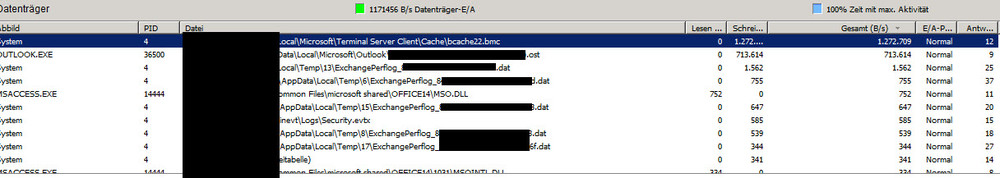

Jein, das ist ja mein Problem. Der Datendurchsatz fällt ja angeblich auf 1-2MB/s, bei 50 Usern dann zu sagen wer schuld ist weil gerade diese eine Datei nun seit dem letzten Intervall am meisten gelesen/geschrieben hat ist halt nur ein schöner Verdacht, aber kein Beweis. Da steht ja nur "Datei X hat in den letzten Sekunden Y-Bytes gelesen/geschrieben" aber nicht "Datei X verursacht 99,99% der Zugriffe in den letzten 5 Minuten" und das ist hier leider bei weitem nicht immer das Selbe. :( Hier mal der letzte Screenshot im Moment des Problems. -

Plattenlast Terminalserver - Wie schuldigen finden?

Zebbi antwortete auf ein Thema von Zebbi in: Windows Server Forum

Danke, das erklärts und das wäre eigentlich die Lösung, aber da das Ganze ja nur sporadisch ist fehlt mir (besser gesagt meinem Chef) noch der Beweis das es wirklich daran liegt. Gibts da keinen Kniff um doch noch irgendwie mitzuloggen was/welche Datei gerade die Platte auslastet? Ich glaub das könnte mir auch bei einigen anderen Problemen sehr helfen. -

Plattenlast Terminalserver - Wie schuldigen finden?

Zebbi antwortete auf ein Thema von Zebbi in: Windows Server Forum

Hi Norbert, die Leitung ist wirklich so dünn und mehr gibts hier auch erstmal nicht. Onlinemodus ist getest und als unzumutbar eingestuft, genau deswegen landen auch die freigegeben Postfächer bewußt mit in der OST. Wenn das Maximum wirklich 50GB ist (ich könnte schwören ich hätte schon eine 70er gesehen) erklärt es das natürlich, hilft mir aber noch nicht den direkten Zusammenhang zu beweisen den ich brauch um das Geld für z.B. eine Mail-Archivierungssoftware zu bekommen. -

Plattenlast Terminalserver - Wie schuldigen finden?

Zebbi hat einem Thema erstellt in: Windows Server Forum

Hallo, ich hab hier mehrere 2008R2 Terminalserver übernommen auf denen noch ein Outlook 2010 läuft sowie einen externen Exchange, weshalb wir hier auf den Cachemodus angewiesen sind. Da das alleine ja nicht schlimm genug ist, liegen die lokalen OST-Datein dummerweise auf der gleichen physikalischen Platte wie das OS der Terminalserver und je größer die OST-Dateien werden, desto häufiger kommt es vor, dass bei dem ein oder anderen User mal ein Outlook abstürzt. Leider kommt Outlook beim nächsten Start auf die Idee, die teils 50GB große .OST-Datei auf Fehler überprüfen zu wollen. Das ist zwar sehr nett gedacht, führt aber i.d.R. zu 100% Last auf der Platte und damit praktisch zum Stillstand des ganzen Servers für alle User bis diese Datei repariert ist. Im Ressourcenmonitor kann ich dann (sofern ich überhaupt noch drauf komme) 100%-Plattenauslastung bei 1-2 MB Datendurchsatz sehen. Bisher kann ich allerdings noch nicht beweisen, dass es wirklich die übergroßen OST-Dateien in Verbindung mit reperaturversuchen durch Outlook sind. Ich habs mit der Leistungsüberwachung probiert, in dem ich die Physikalische Platte überwache, aber Beweise bringt mir das auch nicht, da es ja die verursachenden Dateien nicht mit auflistet. Habt Ihr eine Idee wie ich es sicher Beweisen kann und idealer weise wie ich das bestehende System zukünfig vor sowas schützen kann? Klar, die OSTs müssen VIEL kleiner werden und am besten von der OS-Platte verschwinden, aber sonst noch Ideen? Ein lokaler Exchange steht leider nicht zur Debatte. -

Umzug eines Systems auf aktuelles Windows und Beibehaltung Hostname/IP

Zebbi antwortete auf ein Thema von Samoth in: Windows Server Forum

Was willst Du denn sonst machen? Du kannst das mit dem DNS-Alias ja leicht ausprobieren. Verpass dem neuen System einen neuen Namen und installiere alles. Erzeug ein Alias und trag den auch in die .host ein. Dann schau ob du drauf zugreifen kannst. Wenns geht fahr das Prod-Sys. runter und ändere den Alias (auch in der .host) auf den Prod.-Namen und teste es live. Ein komplettes SAP mal eben so ohne Aufwand umziehen... hat schon seinen Grund das die so viel kassieren...Life is Pain. ;) -

User können im Umgeleiteten Startmenü nichts auswählen

Zebbi antwortete auf ein Thema von Zebbi in: Windows Server Forum

Ich glaub ich habs und es ist so simpel wie dämlich! Da ja nur Admins schreibenden Zugriff haben sollten und User nur lesenden, war auch in dem share nur schreibrecht für Admins, alle Anderen durften nur "lesen". Nun hat "Jeder" "Vollzugriff" (was ja auf Dateiebene sowieso eingeschränkt wird) und es funktioniert... bisher . Wenn der Schreibzugriff also schon im Share verweigert wird, gehts nicht; aber wenn das Dateisystem den Schreibzugriff verweigert, ist das Ok... -

User können im Umgeleiteten Startmenü nichts auswählen

Zebbi antwortete auf ein Thema von Zebbi in: Windows Server Forum

Ich hab die Rechte nochmal neu gesetzt und den "Ersteller/Besitzer" rausgeworfen. Nun dürfen nur noch System&Admins lesen+schreiben und Authentifizierte Benutzer lesen+ausführen. Ein Rechtsklick im Startmenü um die Eigenschaften anzuzeigen geht übrigens auch nicht... -

User können im Umgeleiteten Startmenü nichts auswählen

Zebbi antwortete auf ein Thema von Zebbi in: Windows Server Forum

Ja, so hab ich auch umgeleitet, auf einen versteckten Share. -

User können im Umgeleiteten Startmenü nichts auswählen

Zebbi antwortete auf ein Thema von Zebbi in: Windows Server Forum

Mehr Server sind bei uns auch nicht, dachte nur ich mach das mal "richtig", nun hab ich den Salat. :) Danke für den Tipp, dann werde die Umleitung wieder rausnehmen und das lokal glattziehen. -

User können im Umgeleiteten Startmenü nichts auswählen

Zebbi antwortete auf ein Thema von Zebbi in: Windows Server Forum

Wird das nicht schnell unübersichtlich? Dachte eigentlich mein Weg wäre der Standard auf Terminalserverfarmen. :( -

User können im Umgeleiteten Startmenü nichts auswählen

Zebbi antwortete auf ein Thema von Zebbi in: Windows Server Forum

Hat wirklich keine eine Idee, oder ist das was so dämliches, das es keiner Antwort würdig ist? Ich hüner damit nun schon ein paar Tage rum und sehe vermutlich den Wald vor lauter Bäumen nicht. -

User können im Umgeleiteten Startmenü nichts auswählen

Zebbi hat einem Thema erstellt in: Windows Server Forum

Hallo, ich bin auf die dumme Idee gekommen das Startmenü unserer Windows Server 2008R2 Terminalserver, je nach Abetilung, per GPO Umzuleiten. Optisch funktioniert das auch, jeder User sieht das Abteilungs-Startmenü, aber sobald ein User etwas angeklickt hat, scheint er darauf exclusive Rechte zu bekommen. Die anderen Benutzer können den Punkt anschließend nicht mehr auswählen, beim anklicken passiert einfach nichts. Den Punkt "Exclusive Rechte gewähren" in der GPO hab ich aber deaktiviert. Laut NTFS-Berechtigung dürfen: Authentifizierte Benutzer: Lesen, Lesen und Ausführen. System und Admins: Alles GPO (nach LoopBack) Benutzerkonfig.\Windows-Einst\Ordnerumleitung\Startmenü Dem Benutzer exklusive Zugriffsrechte erteilen für Startmenü Deaktiviert Inhalt von Startmenü an den neuen Speicherort verschieben Deaktiviert Umleitungsrichtlinie auch auf die Betriebssysteme Windows 2000, Windows 2000 Server, Windows XP und Windows Server 2003 anwenden Deaktiviert Verhalten bei Entfernen der Richtlinie Inhalt belassen Hat jemnad eine Idee was ich da falsch gemacht hab? -

Server 2008R2 Terminalserver (physikalisch) mit Remote-FX und Soft-GPU?

Zebbi antwortete auf ein Thema von Zebbi in: Windows Server Forum

Da es physikalisch sein soll fehlt mir leider die extra Hardware dafür und die vorhandene kann ich mangels Erweiterungskarten nicht "mal eben so" aufrüßten. :( -

Server 2008R2 Terminalserver (physikalisch) mit Remote-FX und Soft-GPU?

Zebbi antwortete auf ein Thema von Zebbi in: Windows Server Forum

Stimmt natürlich. :( Ja, mit 2016 würde das gehen. Bleibt die Frage ob das dann mit 2016 performanter ist Remote-FX mit Soft-GPU zu nutzen anstatt klassisches RDP zu nutzen. -

Server 2008R2 Terminalserver (physikalisch) mit Remote-FX und Soft-GPU?

Zebbi antwortete auf ein Thema von Zebbi in: Windows Server Forum

Also schließen sich physikalische Installation, Remote-FX und Soft-GPU per Definition gegenseiteig aus. :( Würde es denn (ganz allgemein gesprochen), rein von der Multimedialeistung her, Sinn machen den Terminalserver zu virtualisieren um Remote-FX mit einer Soft-GPU nutzen zu können; gegenüber dem reinen physikalischem Terminalserver mit klasischem RDC? Die CPU-Last ist nun einstellig und es wären nur wenige User mit sporadischem Multimedabedarf (gelegentlich mal betrachtung eines Werbevideo usw.).