wznutzer

Members-

Gesamte Inhalte

513 -

Registriert seit

-

Letzter Besuch

Alle erstellten Inhalte von wznutzer

-

M365 Brute-Force Angriffe

wznutzer antwortete auf ein Thema von wznutzer in: Windows Forum — Security

Nutzt Ihr MFA von nicht vertrauenswürdigen Standorten? -

M365 Brute-Force Angriffe

wznutzer antwortete auf ein Thema von wznutzer in: Windows Forum — Security

Tatsächlich kenne ich die Karte im Microsoft-Authenticator nicht. Firmenname und Login, mehr sehe ich nicht und der Dialog ist auch modal, die App wartet mit der nächsten Meldung bis ich auf die aktuelle reagiert habe. Dann muss der Angreifer einen Zeitpunkt erwischen, zu dem ich mich anmelde und dann noch zufällig die Nummer stimmen. Spätestens bei der zweiten Abfrage wäre ich stutzig. Aber ich vergesse immer wieder, dass das ja Massenabfragen sind und nicht ein ganz bestimmter Account erobert werden soll, sondern „nur“ irgendwelche und irgendwer gibt dann 30x die gleiche Nummer in den Prompt ein und wundert sich, dass sein Login nicht geht. D. h. wir können nur die Leute sensibilisieren, dass alle Ungereimtheiten beim Login-Prozess gemeldet werden und Conditional-Access nutzen. Z. B., dass sich die Empfangsdame nur von vertrauenswürdigen Standorten aus anmelden darf. Kann man im Tenant eine Regel konfigurieren, dass man nach X Anmeldeversuchen Y Sekunden bis zur nächsten Eingabe warten muss? Ich finde nichts derartiges. -

Hallo zusammen, ich frage mich, wie man die Aussage begründen kann, dass MFA das Durchprobieren nicht eliminieren kann? Die reine Meldung, die man nur bestätigen konnte (im Authenticator), auch versehentlich, gibt es ja nur noch in Verbindung mit dem RDS-Gateway. https://www.heise.de/news/Grossflaechige-Brute-Force-Angriffe-auf-M365-vorsichtshalber-Log-ins-checken-10252167.html Grüße und noch einen schönen Nachmittag

-

RDS Verbindungen für fünf Benutzer einrichten

wznutzer antwortete auf ein Thema von Lendrin in: Windows Server Forum

Vielleicht läuft es auf das klassische „es kommt darauf an“ raus. Ich habe eine kleine unabhängige Cloudumgebung. Die hat einen Jumphost. Der ist per RDP von einer meiner IPs erreichbar. Vom internen Netzwerk aus dürfen wiederum nur 3 VMs auf diese externe IP zugreifen. Der Jumphost hat nicht das Standardzertifikat. Um die Paranoia zu streicheln ist noch das mit der FIPS Verschlüsselung aktiv. Aber Du hast mit Sicherheit recht, wenn man sagt, dass es pauschal zu unterlassen ist, außer man hat ein paar gute Gründe es trotzdem zu tun. Ich hoffe meine sind gut genug :-). -

RDS Verbindungen für fünf Benutzer einrichten

wznutzer antwortete auf ein Thema von Lendrin in: Windows Server Forum

Da würde ich gerne einhaken. Warum sollte ich den Zugriff auf einen RDP-Port (3389) nicht aus einem von mir kontrolliertem Netzwerk, über das Internet, erlauben. Letztendlich macht es doch dann keinen Unterschied, ob ich das auch lokal mache. -

AD-Sicherheit / Auflistung von Usern und Gruppenmitgliedschaften einschränken

wznutzer antwortete auf ein Thema von wznutzer in: Active Directory Forum

Jetzt wird es hell. Der Default Security Descriptor . -

AD-Sicherheit / Auflistung von Usern und Gruppenmitgliedschaften einschränken

wznutzer antwortete auf ein Thema von wznutzer in: Active Directory Forum

Ich glaube ich würde es verstehen, wenn ich wüsste was der DefaultSD ist . -

UPN für AD-User auf beliebigen Wert setzen - dumme Idee?

wznutzer antwortete auf ein Thema von wznutzer in: Active Directory Forum

In diesem Fall wäre es für die Nutzer ein weiterer Accountname den sie sich merken müssen. Die eigene Email-Adresse wissen die, unabhängig von der Länge, schon. -

Active Directory - beschränken der RPC-Ports - ein Lastenproblem?

wznutzer antwortete auf ein Thema von wznutzer in: Active Directory Forum

Der "Mehrwert" war ein Irrtum meinerseits. -

Windows 11 mit 4K Monitor - Skalierung in RDP-Sitzungen zu W2K22

wznutzer antwortete auf ein Thema von wznutzer in: Windows 11 Forum

Danke. Das verhält sich bei mir so, dass die initiale Skalierung (bei Verbindungsherstellung) beibehalten wird. Beispiel: RDP-Start im Vollbild = Skalierung korrekt. Mit intelligenter Größenänderung kann ich das Fenster verkleinern, aber dann wird auch alles kleiner. RDP-Start z. B. mit 2560x1600 (der Monitor hat 3840x2560 3:2) = keine Skalierung, winzige Schrift. Jetzt kann ich das Fenster groß ziehen, dann wird auch alles größer aber auch matschig und ich kann das Fenster kleiner machen, dann wird alles kleiner. Ich hätte z. B. gerne 2560x1600 und 150% Skalierung - Wenn man den Remote Desktop Manager nutzt und in den Kompatibilitätseinstellungen für High DPI "Hohe DPI-Skalierung überschreiben" auf "System (erweitert) stellt, zeigt es bis jetzt das beste Ergebnis. Nicht richtig gut, aber besser als alle anderen Versuche. -

Windows 11 mit 4K Monitor - Skalierung in RDP-Sitzungen zu W2K22

wznutzer hat einem Thema erstellt in: Windows 11 Forum

Hallo und guten Tag, evtl. blamiert man sich mit so einer Frage. Wenn ich von einem 4K Screen eine RDP-Verbindung zu einem RDSH W2K22 herstelle, skaliert die Sitzung nur korrekt wenn man das im Vollbild macht. Das ist sowohl in der mstsc.exe oder mit der Store-App so. Vollbild = korrekt skaliert, also so wie lokal, sobald ich aber eine etwas andere Auflösung einstelle, skaliert gar nichts mehr und die Schrift ist winzig klein. Schön wäre wenn die RDP-Sitzung nicht im Vollbild laufen müsste und trotzdem alles korrekt skaliert werden würde. Man kann im RDP-Client auch zoomen, aber das sieht dann matschig aus. Ebenso kann es der Remote Desktop Manager (rdcman.exe) nicht. RDCMAN.exe skaliert schon, aber es sieht matschig aus. Kennt Ihr zufällig eine Lösung? -

Active Directory - beschränken der RPC-Ports - ein Lastenproblem?

wznutzer antwortete auf ein Thema von wznutzer in: Active Directory Forum

Das mit der Performance hat mir der Github-Copilot gesagt . In dem Konstrukt gibt es ein Segment Management (AD, MS SQL-Server usw, praktisch Tier0 und Tier1). Da kann fast alles miteinander sprechen. Naja fast, ich habe mich ein wenig mit Microsegmentierung per Windows-Firewall ausgetobt. Dann gibt es das Segment Anwender (Tier2) mit Domänenmitglieder. Standardmäßig muss RPC für LSA, SAM, NetLogon 49152-65535/TCP offen sein. Ich dachte großer Portbereich = böse, lieber weniger Ports. An die Sache, dass dann auch immer klar ist, wo eine Session zu suchen ist, bin ich nicht gekommen. Kann man dann sagen, dass aus Sicht der Sicherheit die Portbeschränkung (man würde den Bereich ja nur für die DCs freigeben), außer einem wohligen Bauchgefühl, nicht so sehr was bringt? Danke und Grüße -

Windows 11 - Windows-Updates - Download extrem langsam.

wznutzer antwortete auf ein Thema von wznutzer in: Windows 11 Forum

Oh je. Das würde zumindest soweit passen, weil alles Telekom DSL 50/100 ist. -

Windows 11 - Windows-Updates - Download extrem langsam.

wznutzer hat einem Thema erstellt in: Windows 11 Forum

Hallo zusammen, seit ungefähr Oktober beobachte ich das Problem, dass der direkte Download von Windows-Updates und Updates aus dem Microsoft-Store extrem langsam ist. Es betrifft Windows 11 und 10. Die Geräte sind allesamt im privaten Umfeld, also keine Domäne oder WSUS. Es betrifft unterschiedliche Geräte, auch komplett neu aufgesetzte Notebooks. Der Download ist teilweise 1-3 kb/s. Das geht dann eine Weile so und auf einmal rennt der Download dann mit voller Leitungsgeschwindigkeit, wie wenn man auf einen Slot warten muss. Andere Downloads parallel gestartet laufen immer mit voller Leitungskapazität. Die Downloads in der Firma per WSUS laufen gewohnt schnell. Hat dieses Problem evtl. auch schon jemand beobachtet? Die Optionen der Übermittlungsoptimierung haben darauf keinen Einfluss. Grüße und Danke. -

Active Directory - beschränken der RPC-Ports - ein Lastenproblem?

wznutzer hat einem Thema erstellt in: Active Directory Forum

Hallo und guten Tag, weil ich meine DCs per Firewall vom Rest trennen will, würde ich gerne die dynamischen Ports beschränken. Mircosoft hat es gut beschrieben und es funktioniert auch. Hat jemand Erfahrung damit, ob es evtl. ein Lastenproblem geben könnte oder kommen die DCs gut damit klar, wenn alles über ein Port läuft? Microsoft: https://learn.microsoft.com/de-de/troubleshoot/windows-server/active-directory/restrict-ad-rpc-traffic-to-specific-port Grüße und einen schönen Tag. -

AD-Sicherheit / Auflistung von Usern und Gruppenmitgliedschaften einschränken

wznutzer antwortete auf ein Thema von wznutzer in: Active Directory Forum

Ist es OK das zu verwenden, ist ja schon etwas älter, aus 2003? -

AD-Sicherheit / Auflistung von Usern und Gruppenmitgliedschaften einschränken

wznutzer antwortete auf ein Thema von wznutzer in: Active Directory Forum

Fall das auch jemand bauen will. Ich habe mich dazu entschieden, die Rechte auf den OUs nicht zu entfernen (authentifizierte Benutzer), sondern stattdessen ein explizites verweigern zu setzen. Der einfache Grund ist, dass beim scripten mit dsacls es nicht möglich ist, einzelne Rechte zu entfernen. Es funktioniert so aber auch prima. -

AD-Sicherheit / Auflistung von Usern und Gruppenmitgliedschaften einschränken

wznutzer antwortete auf ein Thema von wznutzer in: Active Directory Forum

Hoppla, dann unerwartet für mich . Aber schön, dass man immer noch dazulernen kann. -

AD-Sicherheit / Auflistung von Usern und Gruppenmitgliedschaften einschränken

wznutzer antwortete auf ein Thema von wznutzer in: Active Directory Forum

Hallo und guten Tag, ich habe mal noch ein wenig rumgespielt um zu verstehen wie das mit dem ListMode funktioniert. ohne ListMode (dsHeuristics) 1) Man kann auf die Idee kommen, einfach den OUs das Recht "Inhalt auflisten" zu entziehen. Auf den ersten Blick funktioniert das. Man sieht als "normaler" Nutzer z. B. in den RSAT-Tools dann die Benutzer unter der OU ohne "Inhalt auflisten" nicht mehr und auch keine Unter-OUs. Aber Nutzer in Unter-OUs werden in Suchen angezeigt. OU001 ("Inhalt auflisten" entfernt) OU001.01 - nicht sichbar Usr002 - z. B. in RSAT-Tools nicht sichbar, aber in Suchen schon. Usr001 - nicht sichtbar Das scheint daran zu liegen, dass das AD die Berechtigungen auf eine unerwartete Art auswertet und der Kombination mit vererbten und direkt zugewiesenen Rechten. In diesem Fall ist das Recht "Inhalt auflisten" bei der Unter-OU OU001.01 noch gesetzt und somit kann der User Usr002 gefunden werden. Die Auswertung der Rechte scheint so zu sein: 1. verweigern, direkt zugewiesenen 2. erlaubt, direkt zugewiesenen 3. verweigern, vererbt 4. erlaubt, vererbt Sobald eine Bedingung zutrifft wird nicht weiter ausgewertet. D. h. ein vererbtes verweigern ist schwächer als ein direktes erlauben. Darauf muss man auch erst mal kommen. 2) Weiterer Versuch ohne AD ListMode. Man ersetzt einfach in der entsprechenden OU "Authentifizierte Nutzer" durch eine Gruppe die alle Benutzer- und Computerobjekte der entsprechenden OU enthält. Funktioniert prima, für alle außerhalb der OU sind die Inhalte nicht sichtbar, auch nicht in Suchen. GPOs werden sauber abgearbeitet. Aber je nach Tool mit dem man das AD anschaut, sieht man die oberste OU mit dem tatsächlichen Namen als "unbekannt". mit ListMode (dsHeuristics) Hier gehen die Infos wild durcheinander und sind teilweise schlicht falsch oder vielleicht auch einfach nur veraltet. Teilweise wird behauptet, dass "Inhalt auflisten" dann nicht mehr gebraucht wird oder auch die Vererbung unterbrochen werden muss. Evtl. waren aber auch die Microsoft-Entwickler bei der Idee betrunken. 1) Ist der ListMode aktiv und es wird bei einer OU das Recht "Inhalt auflisten" entzogen, verhält es sich anders als ohne ListMode. Es werden dann trotzdem noch die Unter-OUs, aber nicht direkt zugeordnete Benutzer-/Computerobjekte angezeigt. 2) Man darf nicht den Fehler machen und den Namen der Rechte versuchen einen Sinn zu geben um das zu verstehen. "Inhalt auflisten" und "Objekt auflisten" stehen in direktem Bezug zueinander: Ein Objekt (OU, Benutzer, Computer usw.) sieht man dann, wenn das zugreifende Objekt (mein Scope) das Recht "Objekt auflisten" auf dem anzusehenden Objekt besitzt und man auf dem Elternobjekt das Recht "Inhalt auflisten" hat. Es gibt also eine strikte Beziehung zwischen Objekt (Objekt auflisten) und Elternobjekt also Parent (Inhalt auflisten). Anhand der obigen Regel lässt sich das ganze Verhalten erklären. Außer es handelt sich um Computerobjekte. Die sieht man auch dann nicht, wenn man auf dem Computerobjekt das Recht "Objekt auflisten" besitzt und man auf dem Elternobjekt das Recht "Inhalt auflisten" nicht hat. Bei Benutzerobjekten hat man das Recht nicht standardmäßig. Wenn man solche Sachen macht, sollte man sich die Verarbeitung der GPOs anschauen. Im meinem Fall funktioniert es wunderbar, wenn man pro Mandant eine Gruppe hat in der alle Benutzer- und Computerobjekte drin sind und diese die entsprechende OU lesen können. Also praktisch eine mandantenspezifische "authentifizierte Benutzer - Gruppe". -

AD-Sicherheit / Auflistung von Usern und Gruppenmitgliedschaften einschränken

wznutzer antwortete auf ein Thema von wznutzer in: Active Directory Forum

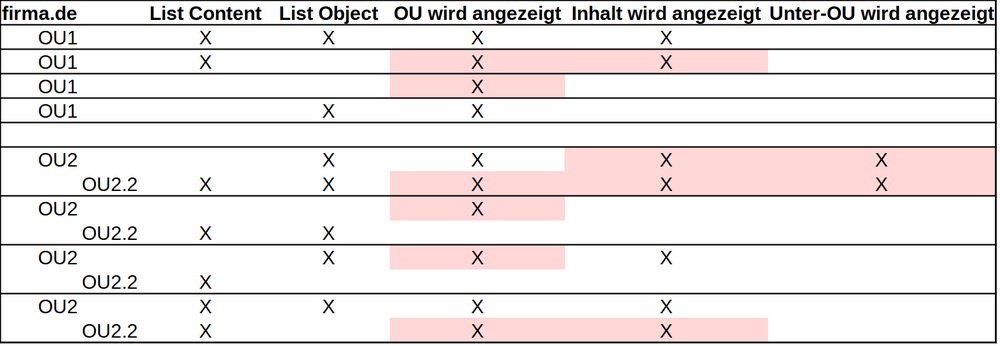

Hallo, ich verstehe den List Mode (dsHeuristics) nicht. Es gibt List Content und List Object. Aber es macht nicht das was es soll bzw. wie es heißt und das noch abhängig, ob es eine Unter-OU gibt. Wenn ich z. B. bei der OU2 (siehe unten) die Berechtigung List Content entferne, wird der Content trotzdem angezeigt. Rot verhält sich irgendwie nicht wie erwartet. Evtl. kann mich jemand in die richtige Richtung schubsen. -

AD-Sicherheit / Auflistung von Usern und Gruppenmitgliedschaften einschränken

wznutzer antwortete auf ein Thema von wznutzer in: Active Directory Forum

Nachtrag: Genau das ist mir noch nicht klar, ob und was ich mit dsacls setzen muss. -

AD-Sicherheit / Auflistung von Usern und Gruppenmitgliedschaften einschränken

wznutzer antwortete auf ein Thema von wznutzer in: Active Directory Forum

Es ist eine Mischung aus beidem. Meinst Du die Berechtigungen auf AdminSDHolder oder auf einzelnen OUs? OK, das muss ich mir dann nochmals anschauen. Ich habe den Registry Key gesetzt und evtl. deswegen keinen Unterschied festgestellt. Ich bin mir nicht sicher, ob wir unter „Automatisierung“ das gleiche verstehen. Ich habe für meinen Fall ein Powershell-Script um einen User anzulegen. Beim ersten User der Gruppe wird auch die OU angelegt und die Berechtigungen mit dsacls gesetzt. Also schon „automatisch“, aber halt ohne irgendein großartiges System dahinter. Im Prinzip ist es so, dass das Script „nur“ für mich klickt. Wenn Du mir noch sagst, welches Buch, kaufe ich mir das am Ende noch :-). -

AD-Sicherheit / Auflistung von Usern und Gruppenmitgliedschaften einschränken

wznutzer hat einem Thema erstellt in: Active Directory Forum

Hallo und guten Tag, es ist gut möglich, dass ich da etwas nicht ganz verstanden habe. Ziel Normalen Usern soll es nicht erlaubt sein z. B. Mitgliedschaften von privilegierten Konten abzufragen oder Objekte (Benutzer, Computerobjekte) außerhalb ihrer eigenen OU sehen zu können. Was zu tun ist. Man leert die Gruppe Prä-Windows 2000. Man entfernt die Authentifizierten Benutzer vom AdminSDHolder-Objekt oder (besser) ersetzt das durch eine vorerst leere eigene Gruppe. Wenn nötig könnte diese Gruppe dann erweitert werden. Man entfernt auf den entsprechenden OUs ebenfalls die Authentifizierten Benutzer und ersetzt diese durch die Gruppe der berechtigen User. Es scheint zu funktionieren, aber ist es auch gut so? 1) Es gibt noch den Registry Key „List Object“ unter HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Services\NTDS\Parameters. Ist das gesetzt, sollen Objekte nur noch gelistet werden, wenn das Recht vorhanden ist. Ich kann keinen Unterschied feststellen, ob dieser gesetzt ist oder nicht. Es hängt alles am expliziten Recht. Brauche ich das? 2) Muss man die Berechtigungen von OUs wirklich über ldp.exe setzen? Ich habe mal irgendwo gelesen, dass das der beste Weg sein soll. Zum Anschauen ist es jedenfalls besser. Es funktioniert, aber muss es sein? 3) Man kann ja trotzdem noch die Standardgruppen sehen. Ist das ein Problem? Ich will ja nicht verhindern das AD zu sehen, sondern nur evtl. das Auskundschaften erschweren. Grüße und ein schönes Wochenende -

UPN für AD-User auf beliebigen Wert setzen - dumme Idee?

wznutzer antwortete auf ein Thema von wznutzer in: Active Directory Forum

Hi, es ist "nur" eine Übergangslösung für ca. 2 Jahre. Bis der Softwareanbieter eine Webapplikation gebaut hat. Mehrere Forests, Domänen oder Vertrauensstellungen wird es nicht geben. Danke für den Hinweis. -

UPN für AD-User auf beliebigen Wert setzen - dumme Idee?

wznutzer hat einem Thema erstellt in: Active Directory Forum

Guten Abend und ein frohes Neujahr, in einem komplett neu aufgesetzten AD sollen sich die User mir "ihrer" Email-Adresse anmelden können. D.h. die Email-Adresse ist eindeutig, hat aber natürlich gar nichts mit meiner Domain zu tun. Hat man selber mehrere Domains kann man das mit einem Suffix machen. Das ist aber für diesen Fall unpraktikabel. Den UPN kann ich sowohl im Attribut selber oder auch per Powershell auf einen beliebigen Wert ändern. Es scheint da keine Plausibilitätsprüfungen auf ein Format (name@domain.de) zu geben. Ebenso funktioniert die Anmeldung, Gruppenauflösung, Replikation usw. völlig problemlos. Exchange, Hybrid oder ähnliches wird es da nie geben. Also in der Domäne firma.de kann es einen User mit dem UPN franz.muster@web.de geben und dieser kann sich problemlos anmelden. Soweit ich weiß wird beim Anmeldeprozess mit einem UPN die lokale Domäne und dann der globale Katalog durchsucht. Der Anmeldeversuch schlägt fehl, wenn dieser nicht gefunden wird. Also es funktioniert, aber ist das eine dumme Idee, es so zu machen? Ich rechne im Lauf der Zeit mit ca. 800 - 1.000 User. Grüße und einen schönen Abend