playaz

Members-

Gesamte Inhalte

178 -

Registriert seit

-

Letzter Besuch

Alle erstellten Inhalte von playaz

-

Windows 10 Domänenrechner mit Azure verbinden (Business Prem. Lizenz)

playaz hat einem Thema erstellt in: MS Azure Forum

Hey, Wir haben unser AD bereits in die Azure Cloud vor einiger Zeit gesynct für Office 365. Nun haben wir Business Premium Lizenzen gekauft wo auch Windows 10 Pro lizenziert ist. Bisher hatten wir immer für Windows 10 einen KMS Key, was ja bei Business Premium nicht mehr der Fall ist, das wird über Azure vergeben. Vorweg; meine Erfahrung mit Azure begrenzt sich auf das Admin Portal und kleineren Einstellungen. Aufgabe: Windows 10 Rechner soll mit der On Prem. Domäne verbunden werden (zwecks GPO, Netzlaufwerke etc) und soll sich zusätzlich mit der Azure verbinden für Office 365 und um den Rechner mit Windows 10 Business Premium zu lizenzieren. Folgende Szenarien: 1. Windows 10 VM erstellt; Rechner in der Workgroup; Melde mich unter Accounts / Work - School Acc / an und erstelle eine Connection zu Azure. Danach trenne ich die Verbindung mit Azure, gebe den Rechner in die lokale Domäne und connecte mich anschließend erneut mit Azure. Ergebnis: Windows wird richtig lizenziert und von Windows 10 Pro wird Windows Business Premium. Er ist in der lokalen Domäne und Zugriff auf alle Ressourcen . Nachteil: Wenn man das bei 100 Usern so machen muss wird man gaga im Kopf. Das kann ja nicht Standard Vorgehensweise sein. Wir haben nur 30 User, aber es muss trotzdem eine bessere, schnellere Möglichkeit geben. 2. Windows 10 VM erstellt; Rechner in die lokale Domäne gehängt; VM wird sofort per KMS aktiviert; lösche ihn mittels slmgr.vbs raus; gehe unter Accounts / Work-School Acc / und verbinde mich mit der Azure Cloud. Hier ist der Unterschied, dass der Rechner nicht Azure JOINED ist sondern Azure registered. Ergebnis: Windows ist zwar mit der Azure verbunden, d.h. Office 365 könnte man installieren; Windows hingegen wird nicht lizenziert. Folgende Fehlermeldung: We can't activate Windows on this device because you don't have a valid digital license or product key. If you think you do have a volid license or key, select Troubleshooter below. Error code: 0xc004F014. Aus meiner Sicht liegt es an dem AD Joined und AD registered. Bei Joined wird die Lizenz herangenommen, bei registered nicht. Mir wurde gesagt, dass es auf jeden Fall funktionieren muss, dass er lokal in der Domäne ist und die Lizenzen über die Azure Connection erhält für das Windows. Da es nur 30 User von über 100 betrifft, möchte ich natürlich den geringst möglichen Aufwand dafür aufwenden. Wie kriege ich das nun hin? vielen Dank! :) -

PS: Amazon S3 Bucket Script Anpassung

playaz antwortete auf ein Thema von playaz in: Windows Forum — Scripting

Vielen Vielen Dank, funktioniert perfekt!! Danke! -

PS: Amazon S3 Bucket Script Anpassung

playaz antwortete auf ein Thema von playaz in: Windows Forum — Scripting

Hi Nils, Vielen Dank. Ich bin absolut kein Scripter oder Programmierer, wüsste nicht wie ich das einbauen könnte das es funktioniert . Aber spuckt google was raus, danke auf jeden Fall für den Tip. -

Hi, folgende Anforderung: Ein Ordner mit hunderten von Files sollen zum Amazon S3 Bucket kopiert werden. Das Script habe ich soweit fertig. Die Files bestehen aus "Datum_Personalnummer_......" zb. "20181218_123456_FILENAME.CSV" Jetzt soll aus dem Filenamen das Datum herausgelesen werden und automatisch ein Ordner angelegt werden im S3 Bucket genau so wie Personalnummer. D.h. unter jedem Datum die jeweilige Personalnummer und in den Ordner soll dann die Datei abgelegt werden. Also 20181218 ----------123456 ----------1255 ----------13252 ----------23456 20181219 ----------123456 ----------1255 ----------13252 ----------23456 Es werden auf einem Netzlaufwerk alle Files (hunderte) in einem Ordner abgelegt, die sollen dann auf den S3 Bucket transferiert werden in dieser Ordnerstruktur. Ich bin kein großer Programmierer oder Skripter deshalb meine Frage an euch was ich an meinem Script anpassen muss um das zu bewerkstelligen. Es müsste lediglich aus dem Dateinamen das Datum und die Personalnummer herausgelesen werden und im Bucket dann der jeweilige Ordner erstellt werden. Mein bisheriges Script das alle *.csv Files rüber kopiert funktioniert auch. Vielen Dank im Vorraus :) $bucket = 'bucketname' $source = 'C:\Scripts\AmazonS3\Upload' $AKey = 'xxxxxxxxxxxxxxxx' $SKey = 'xxxxxxxxxxxxxxxx' $region = 'us-west-2' Initialize-AWSDefaultConfiguration -AccessKey $AKey -SecretKey $SKey -Region $region Set-Location $source $files = Get-ChildItem '*.csv' | Select-Object -Property Name try { if(Test-S3Bucket -BucketName $bucket) { foreach($file in $files) { if(!(Get-S3Object -BucketName $bucket -Key $file.Name)) { ## verify if exist Write-Host "Copying file : $file " Write-S3Object -BucketName $bucket -File $file.Name -Key "Folder1/$($file.Name)" -CannedACLName private } } } Else { Write-Host "The bucket $bucket does not exist." } } catch { Write-Host "Error uploading file $file" }

-

Exch 2010, ISA 2006, TLS 1.2 Support?

playaz antwortete auf ein Thema von playaz in: MS Exchange Forum

Deshalb steht auch im Raum ob wir auf Exchange 2016 (Evtl. Exchange Online) migrieren. Das Exchange Projekte wäre im 1. Quartal nächsten Jahres fällig gewesen. Jedoch haben wir intern noch nicht geklärt ob es eine On Premises Lösung sein wird, eine Hyprid oder eine komplette Cloud Lösung. Wenn wir die Umstellung vorziehen und uns für die Cloud Lösung entscheiden würden, würde zumindest das TLS Thema wegfallen vom ISA. Von den Migrierungskosten wäre es nahzu ident zu der NetScaler Konfiguration. -

Exch 2010, ISA 2006, TLS 1.2 Support?

playaz antwortete auf ein Thema von playaz in: MS Exchange Forum

Wir haben Barracuda FW... habe bereits unseren externen Partner dazu angeschrieben. Danke für die Infos! :) bzgl. ADFS - wollten wir auch demnächst einführen zwecks Office 365 SSO dann wäre das auch eine Alternative. https://www.searchenterprisesoftware.de/tipp/Exchange-im-Internet-veroeffentlichen-ueber-Web-Application-Proxy-und-ADFS -

Exch 2010, ISA 2006, TLS 1.2 Support?

playaz antwortete auf ein Thema von playaz in: MS Exchange Forum

Ich weiß nicht was die Com. Lizenz von Kemp kostet. Aber mir wäre eine NetScaler Lösung lieber da wir den sowieso brauchen. Der NS selbst würde uns kaum was kosten, sondern eher die Dienstleistung was in meinen Augen auch nicht die Welt ist. -

Exch 2010, ISA 2006, TLS 1.2 Support?

playaz antwortete auf ein Thema von playaz in: MS Exchange Forum

Ja klar mit Storefront und 2 Factor Auth. -

Exch 2010, ISA 2006, TLS 1.2 Support?

playaz antwortete auf ein Thema von playaz in: MS Exchange Forum

Meine Linux Kenntnisse sind quasi nicht vorhanden -

Exch 2010, ISA 2006, TLS 1.2 Support?

playaz antwortete auf ein Thema von playaz in: MS Exchange Forum

Eigentlich nicht viel. Proxy, Reverse Proxy und 2 Web Server werden darüber veröffentlicht. Gibt es kostengünstige Alterantiven? Vlt. würde der kostenlose Kemp Loadmaster ausreichen? Das Unternehmen ist nicht sonderlich groß, ca 180 aktive User davon benutzen OWA nur relativ wenige und den anderen Webserver auch nur ein paar User. @testperson Wir haben die VPX10 (habe jetzt nicht all zu viel NS Erfahrung) und mir wurde gesagt das die Standard Lizenz nicht aureicht und mit der VPX10 nicht möglich sei. Den Kemp Loadmaster habe ich mir angesehen, jedoch bietet der in der Free Edt. nur 20mbps, ob das ausreicht? @DocData VPX 10, Standard Lizenz. Derzeit greifen User nur auf das Webinterface zu von extern. -

Exch 2010, ISA 2006, TLS 1.2 Support?

playaz antwortete auf ein Thema von playaz in: MS Exchange Forum

Wir haben einen NetScaler VPX 10 aber keine Enterprise Lizenz. mit der es angeblich nur möglich ist den ISA zu ersetzen. Wir könnten kostengünstig eine höhere VPX mit der ensprechenden Lizenz bekommen nur kostet die Installation einiges. Den ISA will ich sowieso schon längst weg haben. Jetzt ist die Überlegung unseren Exchange 2010 statt im 1Q. 2019 jetzt schon durchzuführen damit wir einmal das TLS Problem gelöst haben. Dann können wir uns immer noch nach einer sauberen Ablöse vom ISA kümmern. Da stellt sich wieder die Grundlegende Frage bzgl. Exchange Online oder On Premises. Danke auf jeden Fall für die Antworten. -

Hi, da MS demnächst TLS 1.0 und 1.1 einstampft und durch TLS 1.2 ersetzt hätte ich ein paar Fargen dazu. Wir haben noch einen alten ISA 2006 auf Windows 2003 Server laufen und Exchange 2010 auf 2008R2. Exchange 2010 TLS 1.2 ready zu machen ist relativ einfach, RU 20 und ein .Net Patch für 2008 R2. Da OWA auch über den ISA Server geht, müsste man den auch TLS 1.2 fit machen oder reicht das es nur der Exchange kann? Meines Wissens nach unterstützt der Server 2003 gar kein TLS 1.2? Der Plan ist nächstes Jahr auf eine aktuelle Exchange Version zu migrieren und den ISA Server durch eine andere Lösung abzulösen. Danke! lg

-

Exch2010 - Zertifikat tausch gegen Wildcard

playaz antwortete auf ein Thema von playaz in: MS Exchange Forum

Eig. war die ganze Mühe umsonst ^^ Ich hab vergessen das wir im bestehenden UCC Zert. 2 unterschiedliche Domains haben von daher benötigen wir sowieso ein neues. Wird einfach verlängert und gut ist. -

Exch2010 - Zertifikat tausch gegen Wildcard

playaz antwortete auf ein Thema von playaz in: MS Exchange Forum

Eigentlich hast du vollkommen recht. Ich werde einfach ein Mail Zert kaufen, aber am FR werde ich mal schauen ob das funktioniert mit dem Wildcard, rein interessehalber. Danke :) -

Exch2010 - Zertifikat tausch gegen Wildcard

playaz antwortete auf ein Thema von playaz in: MS Exchange Forum

Ich bin da komplett leidenschaftslos, ich kann auch ein normales Zert. kaufen. DAS ist nicht das Problem, dachte nur wenn ich eh ein Wildcard hab nehme ich das her... Und danke :) -

Exch2010 - Zertifikat tausch gegen Wildcard

playaz antwortete auf ein Thema von playaz in: MS Exchange Forum

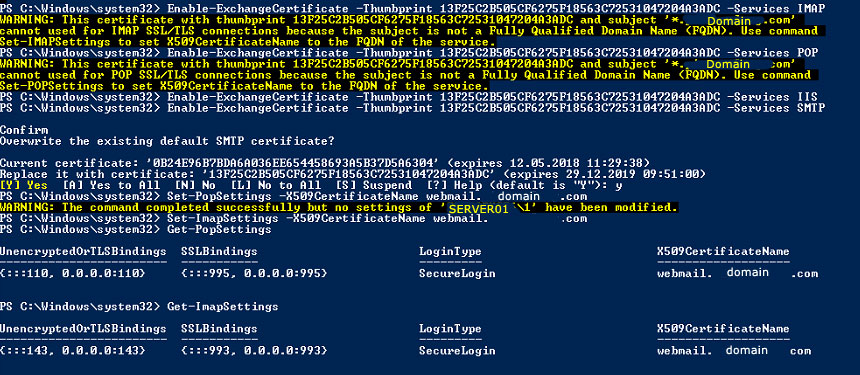

hmm... also durch diese Commands Set-ImapSettings -X509CertificateName webmail.domain.com Set-POPSettings -X509CertificateName webmail.domain.com gebe ich den CN Name an... in meinem Fall werden die Services dem vorhandenen webmail.domain.com Zert. zugeteilt. Wenn ich das richtig verstehe, muss ich dieses rauslöschen.... und die SET-IMAP und POSETTINGS erneut starten dann würde das Wildcard Zert. ran genommen werden? Sorry für die blöden Fragen, mache nie was mit Wildcard Zertifikaten :) -

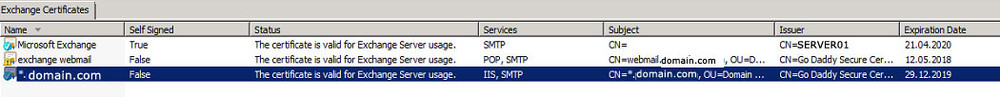

Hi, wir haben einen Exchange 2010 Server bei dem das Webmail Zert. demnächst ausläuft. Ich würde es gerne gegen unser vorhandenes Wildcard tauschen. Habe es nach dieser Anleitung gemacht https://www.lisenet.com/2014/configure-wildcard-ssl-certificate-for-pop-imap-on-exchange-2010-server/ Alle Dienste waren vorher am exchange webmail Zertifikat zugeteilt - mit den Commands wollte ich es auf das Wildcard binden. Was ich mit bekommen habe ist das POP und IMAP nicht zuweisbar ist auf ein Wildcard? Auch das IMAP Service fehlt jetzt in der Liste? Woher weiß der Exchange Server das der CN webmail lautet wenn er nur das Wildcard Zert. hat? Set-POPSettings -X509CertificateName webmail.domain.com Set-IMAPSettings -X509CertificateName webmail.domain.com Wie kann ich nun das Wildcard konfigurieren damit alle Dienste darüber laufen? Das mittlere exchange webmail wird gelöscht werden. Wäre für Tipps sehr dankbar :) lg

-

TS (Citrix): Desktop Lock deaktivieren für bestimmte User (GPO)

playaz antwortete auf ein Thema von playaz in: Windows Server Forum

Es meldet sich in der Früh ein bestimmter User an (dessen Kennwort nur eine Person kennt) und dieser Bildschirm soll den Tag lang nicht gesperrt werden weil ihn mehrere Personen benutzen. Ein Art Kiosk PC wenn man das so will. -

TS (Citrix): Desktop Lock deaktivieren für bestimmte User (GPO)

playaz hat einem Thema erstellt in: Windows Server Forum

Hey, folgendes Szenario: Citrix 7.13 Farm, Server 2012R2 Der Desktop wird standardmäßig nach 15min gelockt und der User muss sich erneut authentifizieren. Es gibt einen Rechner wo sich User über Citrix einloggen der nicht gelockt werden soll. Es funktioniert soweit für einen ganzen Citrix Server - ich möchte jedoch das es nur bestimmte User betrifft - egal auf welchem Server sie eingeloggt sind. Ich habe eine AD Gruppe erstellt NO_Lock und habe folgende GPO's gesetzt Security Options | Interactive Logon: Machine inactivity limit: 0 seconds Admin Templates | System | Group P. | User Group Policy Loopback processing mode: Enabled (Merge) Power Mgm | Sleep Settings | Require a Password When a Computer Wakes (Plugged in): Disabled Power Mgm | Video and Display Settings |Turn Off the Display: Enabled (0) User Config: Control Panel | Personalization | Screen Saver Timeout: Enabled (0) Die GPO wurde zum Testen auf die OU der Citrix Server gesetzt und auf die OU wo sich Testuser befinden. Die Auth. User wurde aus dem Reiter Delegation entfernt stattdessen die AD Gruppe NO_Lock hinzufgefügt und Apply Group Policy gesetzt. Irgendwie scheint es nicht zu klappen, hat jemand nen Tip? Danke! -

Netzlaufwerke verschwinden bzw. nicht sichtbar

playaz hat einem Thema erstellt in: Windows Server Forum

Hi, Wir haben eine neue Citrix Farm mit Windows Server 2012 R2 und XenApp 7.13. Es kommt nun gelegentlich vor, dass die Netzlaufwerke verschwinden - siehe Screenshot. (d.h. sie sind nicht mehr sichtbar) Im "Arbeitsplatz" in der Mitte wo die Laufwerke dargestellt werden, fehlen zb. 4 mappings, links davon kann es sein das 2 doch angezeigt werden (oder gar nichts). Wenn man in die Adressleiste geht und dort den Laufwerksbuchstaben direkt eingibt zb. y: dann kommt man auch auf das Laufwerk drauf. D.h. es ist ein Darstellungsproblem - die Mappings sind immer noch aktiv. Im Eventlog sehe ich keine Fehler. Die Laufwerke werden mittels Startscript gemappt und bis dato hatten wir nie Probleme. Selbst wenn ich das Script erneut ausführe, dann sind sie zum Teil kurz sichtbar, aber kurze Zeit später wieder weg (wie zb. das Homelaufwerk des Users). Das passiert auch nicht bei allen oder sehr oft, aber oft genug das es nervt und gefixt werden muss. Hat jmd einen Tip? Danke! -

Probleme mit DC - EA CA migrieren - kurze Frage

playaz antwortete auf ein Thema von playaz in: Active Directory Forum

Den Fehler konnte ich nicht fixen, k.a. woran es gelegen ist. Ich habe die Rolle jetzt einfach auf einem neuen Management Server (2012 R2) installiert und funktioniert. Das Backup von der alten CA konnte ich nicht einspielen aber ist auch nicht so wichtig. Certs lassen sich erstellen und für mehr benötige ich es eh nicht. -

Probleme mit DC - EA CA migrieren - kurze Frage

playaz antwortete auf ein Thema von playaz in: Active Directory Forum

Danke für die zahlreichen Antworten, Problem selbst gelöst. -

Probleme mit DC - EA CA migrieren - kurze Frage

playaz hat einem Thema erstellt in: Active Directory Forum

Hi, Wir haben letzte Woche gemerkt das einer von zwei DC's nicht mehr synchronisiert (Kollege hatte die VM davor aus dem Backup zurückgesichert weil der DC nicht mehr hoch gefahren ist seither keine sync. mehr). Haben heute den DC demoted (forced) und danach die Certificate Auth. Services Rolle deinstalliert. Nach der Anleitung: http://blogs.technet.com/b/canitpro/archive/2014/11/12/step-by-step-migrating-the-active-directory-certificate-service-from-windows-server-2003-to-2012-r2.aspx Nachdem der DC wieder läuft wollten wir die Rolle wieder installieren, erhalten jedoch einen MMC Error. Ist die Frage wie wir das lösen können? Google hat nichts ausgespuckt. Das Backup lt. Anleitung haben wir gemacht d.h. export des Backups und export der Registry Config. Könnt ich die Auth.CA theoretisch einfach am 2. DC installieren und die Config hernehmen und das Backup oder muss das zwingend der gleiche Server sein? Thx :) -

SSL Cert für Webmail wird nicht übernommen

playaz antwortete auf ein Thema von playaz in: MS Exchange Forum

Testen war das falsche Wort... ich meinte eher das ich gerade dabei war es zu exportieren etc... ;) -

SSL Cert für Webmail wird nicht übernommen

playaz antwortete auf ein Thema von playaz in: MS Exchange Forum

ja auch gerade gemacht vor wenigen Minuten, bin grad am testen edit: hat alles gepasst, funktioniert! Danke! :)